- Раскрытие секретов: Паттерны для работы с распределенными файловыми системами (HDFS)

- Что такое HDFS и почему он так важен?

- Основные паттерны работы с HDFS

- Паттерн 1: Разделение данных по логическим сегментам (Partitioning)

- Паттерн 2: Использование разделов (Partition Files)

- Совет по реализации:

- Паттерн 3: Инкрементальное обновление данных (Incremental Data Loading)

- Тонкости работы с надежностью и отказоустойчивостью

- Паттерн 4: Репликация данных (Replication)

- Паттерн 5: Использование резервных копий (Backup)

- Практические рекомендации по оптимизации работы с HDFS

Раскрытие секретов: Паттерны для работы с распределенными файловыми системами (HDFS)

Мы всегда интересуемся, как обрабатывать огромные объемы данных, где находить баланс между эффективностью и надежностью. В этой статье мы поделимся нашим опытом и знаниями о паттернах работы с одной из самых популярных распределенных файловых систем — HDFS (Hadoop Distributed File System). Прежде чем перейти к практическим рекомендациям и паттернам, давайте разберемся, что же такое HDFS и почему он стал основой для хранения данных в современных больших системах.

Что такое HDFS и почему он так важен?

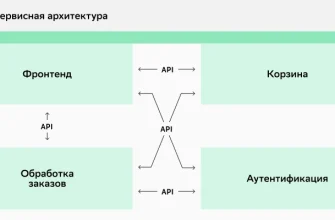

HDFS — это распределенная файловая система, разработанная для хранения больших объемов данных на множестве серверов, соединенных в кластер. Ее главная задача — обеспечить надежное и быстое хранение данных, доступных для анализа и обработки в реальном времени. Именно благодаря своей архитектуре, HDFS позволяет не только масштабировать объем хранения, но и обеспечивать высокую отказоустойчивость, что критично для современных компаний, работающих с данными в масштабах терабайтов и петабайтов.

Основные особенности HDFS включают:

- Масштабируемость: возможность увеличения объема хранения за счет добавления новых узлов.

- Типовая архитектура: мастер-скассер (NameNode) и многосерверные DataNodes.

- Автоматическая репликация: данные дублируются на нескольких узлах для повышения надежности.

- Высокая пропускная способность: оптимизирован для обработки больших потоков данных.

Какие задачи решает HDFS? В основном — хранение логов, обработка больших данных, аналитика, машинное обучение и многое другое. Но чтобы использовать его максимально эффективно, необходимо знать правильные паттерны работы.

Основные паттерны работы с HDFS

Когда мы впервые начали работать с HDFS, столкнулись с рядом особенностей и ограничений. Выработав опыт, мы систематизировали лучшие практики и выявили несколько ключевых паттернов, которые позволяют выжать максимум из этой системы. Ниже представляем их.

Паттерн 1: Разделение данных по логическим сегментам (Partitioning)

Один из самых важных паттернов — правильно организовать структуру хранения данных. Вместо того чтобы класть все файлы в один каталог, разумнее разбивать их по логическим группам — по датам, типам данных, регионам или другим признакам.

Это позволяет:

- Облегчить поиск и обработку данных.

- Снизить нагрузку на NameNode, избегая слишком больших метаданных.

- Обеспечить параллельную обработку сегментов.

| Пример разделения данных | Структура каталогов | Описание |

|---|---|---|

| По датам | /data/2023/10/01 | Каждый каталог, один день. |

| По регионам | /data/region1, /data/region2 | Данные по регионам. |

| По типам данных | /data/logs, /data/transactions | Виды данных. |

Паттерн 2: Использование разделов (Partition Files)

Этот паттерн предполагает разбиение крупного файла на меньшие логические части при помощи разделителей или сегментации. Это позволяет ускорить выборку данных, уменьшает объем считываемых данных и повышает эффективность анализа.

Особенности:

- Обеспечивает быстрый доступ к нужным частям данных.

- Позволяет применять параллельную обработку.

- Облегчает обновление и добавление новых данных.

Совет по реализации:

- Используйте форматы файлов с разделителями, например, CSV, Parquet, ORC.

- Преимущество формата Parquet — его способность хранить схему и поддерживать эффективный columnar storage.

Паттерн 3: Инкрементальное обновление данных (Incremental Data Loading)

Когда обрабатываете данные, очень важно не перезаписывать все существующие файлы, а добавлять только новые или измененные. Это значительно ускоряет обработку и снижает нагрузку.

Реализация этого паттерна:

- Отслеживайте последние обработанные точки, например, по дате или по уникальному идентификатору.

- Загружайте и обрабатывайте только новые данные.

- Объединяйте их с уже обработанными для получения актуальной картины.

| Параметр | Описание | Пример |

|---|---|---|

| Таймстамп | Последнее время обновления | 2023-10-01T12:00:00 |

| Идентификатор партии | Уникальный номер загрузки | batch_00123 |

Тонкости работы с надежностью и отказоустойчивостью

Одной из главных задач является обеспечение высокой отказоустойчивости и защиты данных. Паттерны, связанные с репликацией и резервным копированием, помогают достигнуть этой цели.

Паттерн 4: Репликация данных (Replication)

Каждая запись в HDFS по умолчанию дублируется в нескольких копиях (обычно 3). Это обеспечивает сохранность данных в случае сбоя одного из узлов.

Совет: настройте уровень репликации в зависимости от важности данных и ресурсов кластера.

Паттерн 5: Использование резервных копий (Backup)

Помимо репликации внутри кластера, рекомендуется регулярно создавать резервные копии на внешних носителях или в облаке.

Практические рекомендации по оптимизации работы с HDFS

- Используйте правильные форматы файлов для хранения аналитических данных — Parquet или ORC кроме CSV.

- Разделяйте большие файлы на более мелкие сегменты для быстрой обработки.

- Настраивайте параметры репликации и блокировки в соответствии с инфраструктурой.

- Используйте кэширование данных при повторных запросах для ускорения обработки.

- Планируйте объем и распределение данных так, чтобы избегать узких мест и «горячих точек» в кластере.

Еще один важный момент, правильно организовать процессы ETL (Extract, Transform, Load): загружать только необходимые данные и избегать дублирования.

Как мы убедились, правильное использование паттернов при работе с HDFS — залог эффективности и надежности всей системы. Каждая организация уникальна, и важно подбирать подходящие инструменты в соответствии с объемами данных, целями обработки и инфраструктурой.

Мы рекомендуем постоянно тестировать новые подходы, анализировать результаты и оптимизировать процессы. В конечном счете, умение грамотно выстраивать работу с распределенными файловыми системами — ключ к успешным проектам в области больших данных.

Подробнее

| Запросы | Запросы | Запросы | Запросы | Запросы |

|---|---|---|---|---|

| паттерны работы с HDFS | оптимизация HDFS | репликация данных HDFS | разделение файлов HDFS | обработка больших данных HDFS |

| работа с разделами HDFS | настройка репликации HDFS | учет отказоустойчивости HDFS |