- Преимущества и особенности обработки больших файлов: как не потеряться и извлечь максимум

- Что такое большие файлы и почему их сложно обрабатывать?

- Паттерны для обработки больших файлов

- Паттерн потоковой обработки (Streaming)

- Разбиение файла на части (Chunking)

- Использование базы данных или хранилищ данных

- Практические советы по обработке больших файлов

- Планирование и оценка объема работ

- Автоматизация и скрипты

- Выбор инструментов

- Преодоление распространенных ошибок

- Недооценка объема данных

- Плохая организация потоков обработки

- Нехватка автоматизации

Преимущества и особенности обработки больших файлов: как не потеряться и извлечь максимум

В современном мире объем данных растет экспоненциально․ Мы сталкиваемся с огромными файлами, которые необходимо обрабатывать, анализировать и хранить․ Это создает множество вызовов, связанных с эффективностью работы, быстростью обработки и сохранением целостности информации․ В нашей статье мы расскажем о том, как правильно подходить к обработке больших файлов, какие паттерны используют профессионалы и как избежать распространенных ошибок․

Что такое большие файлы и почему их сложно обрабатывать?

Понятие "большого файла" условно и зависит от контекста: для одних гигабайты — уже большие данные, а для других – тетрабайты и петабайты․ Однако в любом случае такие файлы требуют особого подхода к обработке․ Традиционные методы, применяемые к medium-sized или small files, зачастую не работают или работают очень медленно на больших объемах․

Обработка больших файлов связана с рядом особенностей:

- Ограничения по памяти: большинство программ не способны загрузить огромный файл целиком в оперативную память․

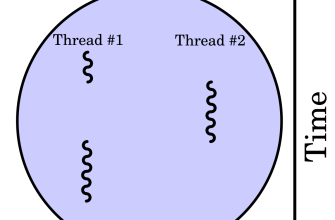

- Производительность: операции с большими файлами требуют много времени, поэтому важно оптимизировать алгоритмы и использовать параллельные вычисления․

- Целостность данных: при работе с огромными объемами важно обеспечить сохранность данных на каждом этапе обработки․

Паттерны для обработки больших файлов

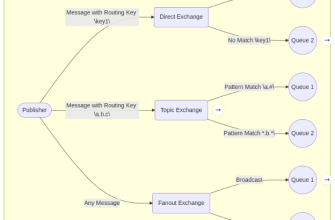

Использование правильных паттернов и методов позволяет значительно упростить обработку больших файлов, сделать работу быстрее и надежнее․ Рассмотрим популярные подходы и техники․

Паттерн потоковой обработки (Streaming)

Один из ключевых паттернов при работе с большими файлами – потоковая обработка․ Она предполагает чтение и обработку данных по частям, а не загрузку всего файла целиком․

- Преимущества: минимальное потребление памяти, возможность работать с файлами любого размера․

- Как реализовать: использование потоковых API, таких как

FileStreamв C# илиio․BufferedReaderв Python․

| Метод | Описание | Преимущества | Недостатки | Примеры |

|---|---|---|---|---|

| Потоковая обработка | Обработка файла по частям (строка за строкой или блок за блоком) | независимость от объема файла, низкое потребление памяти | сложность логики, необходимость ручного управления потоками | Python: with open as f, Java: BufferedReader |

| Разбитие файла на части | Деление файла на сегменты для параллельной обработки | ускорение обработки, использование многоядерных систем | сложность синхронизации и объединения данных | MapReduce, параллельные скрипты |

| Использование специальных библиотек | Библиотеки, реализующие потоковую обработку | легкость реализации, высокая производительность | возможная сложность настройки | Apache Hadoop, Dask, Pandas (чтение по частям) |

Разбиение файла на части (Chunking)

Еще один распространенный метод — это разделение файла на равные части или сегменты, которые обрабатываются отдельно․ Такой подход особенно эффективен, когда необходимо распараллеливание задач․

- Плюсы: возможность распределенного анализа, снижение нагрузки на системные ресурсы․

- Минусы: нужна логика объединения данных и управление метаданными․

Этот подход подходит для обработки больших данных, например, логов, больших таблиц или изображений․

Использование базы данных или хранилищ данных

Иногда целесообразно импортировать большие файлы в специализированные системы, такие как базы данных или хранилища данных․

- Преимущества: быстрое выполнение запросов, автоматическая индексация, надежность хранения․

- Недостатки: необходимость предварительной подготовки данных, затраты времени на импорт․

Рекомендуется для аналитических задач, когда важна быстрота доступа и возможность масштабирования․

Практические советы по обработке больших файлов

Планирование и оценка объема работ

Перед началом обработки важно правильно оценить объем данных и определить конечную цель․ Это позволит выбрать наиболее подходящие инструменты и методы․

- Шаги:

- Анализ размера файла․

- Определение целей обработки․

- Выбор паттерна работы (потоковая обработка, разбиение, использование базы данных)․

- Оценка ресурсов – память, процессорное время, дисковое пространство․

Автоматизация и скрипты

Для обработки больших файлов рекомендуется писать скрипты автоматизации, чтобы снизить риск ошибок и повысить повторяемость процесса․

- Что важно учитывать:

- Обработка ошибок․

- Логи и метаданные․

- Параллельное выполнение задач․

Выбор инструментов

Подбирайте инструменты, исходя из типа данных и требований․ Например:

| Тип данных | Инструменты | Особенности | Примеры |

|---|---|---|---|

| Текстовые файлы | Python, Bash скрипты, sed, awk | Потоковая обработка, поиск, замена | Обработка логов, парсинг CSV |

| Большие таблицы | Pandas, Dask, Spark | Распределенная обработка, разбиение | Обработка данных для аналитики |

| Бинарные файлы | Custom парсеры, C++, Java | Высокая скорость, низкое потребление памяти | Обработка изображений, видео |

Преодоление распространенных ошибок

Недооценка объема данных

Многие сталкиваются с тем, что изначально кажется, что файл можно обработать быстро и легко, а в процессе выясняется, что он занимает намного больше ресурсов, чем предполагалось․ Это ведет к задержкам и сбоям․

Плохая организация потоков обработки

Игнорирование потоков и параллелизма приводит к долгой обработке и простою систем․ Важно научиться правильно настроить потоковую работу и параллельные процессы․

Нехватка автоматизации

Обработка больших объемов данных должна быть максимально автоматизирована, иначе есть риск появления ошибок и потери времени․

Подробнее

| обработка больших файлов | паттерн потоковой обработки | разделение файлов на части | использование базы данных | распараллеливание обработки |

| оптимизация работы с файлами | выбор инструментов обработки данных | ошибки при обработке больших данных | автоматизация процессов обработки | советы по быстрому анализу данных |

| параллельная обработка файлов | планирование крупномасштабных задач | использование потоковых потоков | организация логики обработки | скрипты для обработки больших данных |

| лучшие практики работы с файлами | настройка инструментов для обработки данных | выбор паттернов обработки | надежные методы сохранения данных | эффективные техники анализа больших данных |