- Понимание и использование паттернов для обработки логов в Apache Spark

- Почему важна обработка логов в Spark?

- Что такое паттерны логов и зачем они нужны?

- Виды паттернов для логов

- Паттерны в практике: использование в Spark

- Пример создания паттерна для поиска ошибок

- Лучшие практики создания и использования паттернов

- Дополнительные ресурсы и примеры

Понимание и использование паттернов для обработки логов в Apache Spark

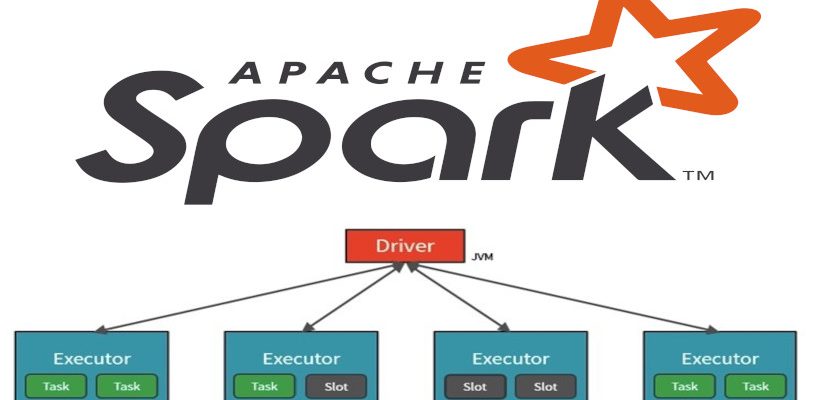

В современном мире обработки больших данных Apache Spark занимает лидирующие позиции благодаря своей скорости и удобству работы с огромными массивами информации. Одним из ключевых этапов работы с данными является анализ логов — файлы, в которых фиксируются все события, происходящие во время выполнения приложений. Для эффективности этого анализа важно правильно распознавать и обрабатывать различные типы паттернов, которые встречаются в логах. В этой статье мы подробно разберемся, каким образом можно использовать паттерны для обработки логов в Spark, какие инструменты помогают делать это максимально эффективно, и на практике рассмотрим основные паттерны, необходимые для работы.

Почему важна обработка логов в Spark?

Обработка логов — это неотъемлемая часть мониторинга и диагностики систем, особенно в распределенной среде, такой как Spark. Логи помогают понять, что происходит внутри ваших приложений, выявить ошибки, определить узкие места и оптимизировать процессы. Без правильной обработки логов, часто становится impossible определить корень проблемы без глубокого анализа огромных объемов данных, что усложняет принятие решений и увеличивает время реакции на инциденты.

Основные задачи, решаемые с помощью обработки логов:

- Анализ ошибок и исключений: быстро находить и устранять сбои.

- Мониторинг производительности: выявлять узкие места и повышать эффективность.

- Аудит безопасности: отслеживать возможные угрозы и несанкционированные действия.

- Оптимизация ресурсов: анализировать использование памяти, CPU и сети.

Что такое паттерны логов и зачем они нужны?

Паттерны логов — это шаблоны, шаблонизированные выражения, предназначенные для поиска и идентификации конкретных строк или фрагментов в лог-файлах. Они помогают автоматизировать процесс выделения интересующих событий, ошибок, предупреждений или других важных сообщений из неструктурированных текстовых данных.

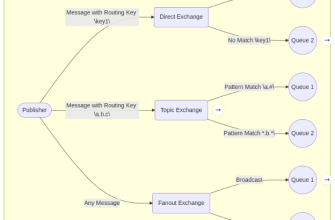

Понимание и правильное использование паттернов значительно облегчает парсинг логов, автоматизацию анализа и интеграцию с системами мониторинга, такими как ELK Stack, Grafana, Prometheus и другие. В основе таких паттернов лежат регулярные выражения, которые позволяют точно находить нужные данные любой сложности — от простой ошибки до сложных цепочек событий.

Виды паттернов для логов

Область применения паттернов довольно широка. Их можно условно разделить на несколько типов, которые полезны в разных сценариях. Ниже приводим основные виды с примерами:

| Тип паттерна | Описание | Пример использования |

|---|---|---|

| Ошибка или исключение | Регулярные выражения для поиска ошибок, исключений, stack trace | Обнаружение NullPointerException в логах Java |

| Время события | Выделение временных меток для анализа последовательности событий | Парсинг timestamp для построения временных графиков |

| Уровень логирования | Фильтрация по уровням: INFO, WARN, ERROR и др. | Отделение ошибок высокого приоритета |

| Пути и имена файлов | Определение путей, маршрутов или имен ресурсов | Поиск запросов к определенной базе данных |

Паттерны в практике: использование в Spark

Реальное применение паттернов для логов в Spark — это создание гибких механизмов для парсинга и фильтрации данных. Благодаря тому, что лог-файлы могут иметь различные форматы и структуру, важно разработать универсальные шаблоны, способные находить нужную информацию без постоянной корректировки.

Для этого часто используют такие инструменты, как Spark SQL, DataFrames и Spark Streaming. В комбинации с регулярными выражениями, эти технологии позволяют не только распарсить логи, но и выполнять их агрегацию, фильтрацию и анализ в реальном времени.

Пример создания паттерна для поиска ошибок

Рассмотрим пример — нам нужно найти все строки, в которых присутствует слово ERROR, и извлечь из них дату и сообщение об ошибке.

val logDf = spark.read.text("hdfs://path-to-logs")

val errorPattern = "^(?\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}) ― ERROR ― (?.+)$"

val errors = logDf

.filter(line => line.getString(0).matches(errorPattern))

.select(

regexp_extract($"value", errorPattern, "date").alias("Дата"),

regexp_extract($"value", errorPattern, "message").alias("Сообщение")

)

errors.show

В этом примере мы используем регулярное выражение для поиска строк, содержащих ошибки, и извлекаем интересующие части данных — дату и сообщение. Аналогичные паттерны помогут выявлять и анализировать различные события в логах.

Лучшие практики создания и использования паттернов

Для эффективной работы с логами при помощи паттернов следует придерживаться нескольких важных правил:

- Понимать структуру лог-файлов: анализировать типы сообщений, формат временных меток, уровни логирования.

- Использовать мощные регулярные выражения: они позволяют точно ловить нужные шаблоны и избегать ложных срабатываний.

- Автоматизировать анализ: все паттерны интегрировать в скрипты и Spark-программы для обработки больших данных.

- Обновлять шаблоны по мере изменения форматов логов: структура логов может меняться, и важно своевременно обновлять паттерны.

- Обеспечивать производительность: избегайте сложных регулярных выражений, вызывающих задержки, используйте компиляцию шаблонов.

Обработка логов — это важнейшая часть работы с данными в экосистеме Apache Spark. Паттерны, основанные на регулярных выражениях, играют ключевую роль в автоматизации поиска, фильтрации и анализа информации, содержащейся в логах. Их правильное создание, адаптация и использование позволяют значительно ускорить диагностику проблем, повысить качество мониторинга и обеспечить безопасность систем.

Понимание принципов работы с паттернами, знание правильных подходов к их созданию и знание инструментов Spark делает возможным максимально эффективно использовать лог-файлы, извлекая из них ценную информацию в автоматическом режиме.

Вопрос: Как создавать эффективные паттерны для поиска сложных событий в логах Spark?

Ответ: Для этого необходимо хорошо разбираться в структуре логов и регулярных выражениях. Важно точно определить уникальные признаки искомых событий и сформировать шаблоны, которые смогут ловить эти признаки. Также рекомендуется тестировать паттерны на небольших выборках логов и оптимизировать их для повышения скорости работы. Использование таких инструментов, как regexp_replace, regexp_extract в Spark, позволяет извлекать и структурировать данные на лету, делая автоматический анализ максимально точным и быстрым.

Дополнительные ресурсы и примеры

Подробнее

| Обработка логов Spark | Регулярные выражения в Spark | Автоматизация логов | Мониторинг Spark приложений | Ошибки и исключения в логах |

| Парсинг логов в Spark | Регулярные выражения для аналитики | Структурирование логов | Логирование и диагностика | Анализ производительности Spark |

| Обработка больших логов | Тонкости regex в Spark | Обучающие материалы по логам | Оптимизация парсинга логов | Безопасность логов в Spark |