- Погружение в обработку логов с помощью Flink: эффективные паттерны и лучшие практики

- Почему выбор Flink для обработки логов — это правильно?

- Основные паттерны для обработки логов с помощью Flink

- Прослойка фильтрации и предобработки данных

- Пример кода

- Обнаружение аномальных поведений

- Пример реализации

- Тайминг и оконные вычисления

- Пример

- Алёрты и оповещения

- Пример

- Индексация и хранение результатов

- Практические рекомендации по построению системы логирования на базе Flink

- Что важно учитывать при разработке паттернов обработки логов?

- Типичные ошибки и как их избегать

Погружение в обработку логов с помощью Flink: эффективные паттерны и лучшие практики

В современных условиях быстро меняющихся технологий логирование становится неотъемлемой частью системы мониторинга и аналитики. Именно умное и эффективное использование потоковых данных позволяет бизнесам быстро реагировать на проблемы, оптимизировать расходы и принимать обоснованные решения. Apache Flink – это мощная платформа для обработки потоковых данных, которая отлично подходит для анализа логов в реальном времени.

Наша команда уже несколько лет занимается экспортной обработкой логов, погружаясь в разнообразные паттерны и подходы к их использованию на практике. Сегодня мы поделимся своим опытом, расскажем о самых популярных паттернах, опасных возможностях и поможет понять, как правильно построить систему обработки логов на базе Flink. В статье вы найдете подробные объяснения, практические советы и примеры реализации.

Почему выбор Flink для обработки логов — это правильно?

Обработка логов в реальном времени — задача, которая требует высокой производительности, надежности и масштабируемости. Именно эти качества делает возможным Apache Flink. В отличие от других систем потоковой обработки, Flink предлагает встроенную поддержку событийно-ориентированной модели, управление временем прохождения событий и возможность обработки данных с высокой точностью.

Использование Flink в системе логирования позволяет:

- Обеспечить низкую задержку обработки, важно для своевременного реагирования на критические ситуации.

- Масштабировать систему — благодаря распределенной архитектуре.

- Обеспечить надежность — возможность обработки потерянных данных и точность данных в Stream Processing.

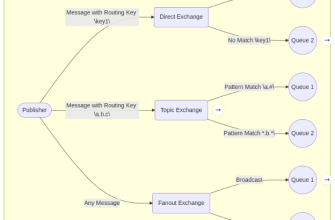

- Интегрировать с различными системами — Kafka, Elasticsearch, системы визуализации и провайдеры облачных решений.

Разработка паттернов для обработки логов на базе Flink помогает избегать ошибок и постичь искусство масштабируемых решений, которые легко адаптируются под требования бизнеса.

Основные паттерны для обработки логов с помощью Flink

Прослойка фильтрации и предобработки данных

Первая и одна из важнейших стадий. Здесь мы фильтруем ненужные записи, исправляем структурные ошибки и делаем первичную агрегацию. Например, исключение логов, не относящихся к критическим или содержащих мусорные данные.

Ключевые моменты:

- Использование фильтров для исключения нежелательных сообщений.

- Преобразование форматов данных — сериализация/deserialization.

- Обогащение логов дополнительной информацией (например, геолокацией по IP).

Пример кода

DataStream<LogRecord> logs = environment

.addSource(kafkaConsumer)

.filter(record -> record.level.equals("ERROR"))

.map(record -> { /* преобразование */ });

Обнаружение аномальных поведений

Паттерн, позволяющий обнаруживать необычные сценарии на основе статистических методов или машинного обучения. В логах могут возникать неожиданные пики по частоте ошибок, изменения паттернов входящих соединений, изменение задержек.

Пример решений:

- Внедрение алгоритмов кластеризации — например, DBSCAN, K-means.

- Использование правил для обнаружения аномалий.

- Интеграция с системами обучения для адаптивного анализа.

Пример реализации

// Детектор аномалий на основе статистического анализа

public class AnomalyDetector extends KeyedProcessFunction<String, LogRecord, String> {

// Логика определения аномалии

}

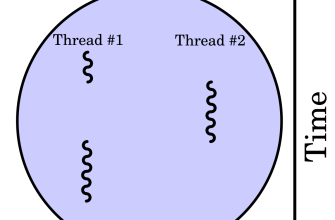

Тайминг и оконные вычисления

Обработка логов часто требует анализа периода времени. Например, подсчет количества ошибок за последние 5 минут или более сложные временные паттерны.

Использование оконных вычислений помогает сгруппировать данные по времени для анализа динамики событий:

- Тумбовые окна (Tumblers)

- Скользящие окна (Sliding windows)

- Сеансовые окна (Session windows)

Пример

logs .keyBy(record -> record.source) .window(SlidingEventTimeWindows.of(Time.minutes(5), Time.minutes(1))) .aggregate(new ErrorCountAggregator);

Алёрты и оповещения

Паттерн для своевременного оповещения операторов или систем автоматического реагирования. В результате обработки логов формируем оповещения, когда обнаружена критическая ситуация — например, много ошибок подряд, сбои систем или попытки взлома.

Используем API Flink для генерации алёртов и интеграции с системами нотификаций, например, Slack, email или системами тревог.

Пример

if (errorCount > threshold) {

// отправка алёрта

}

Индексация и хранение результатов

Обработка логов не завершается на этапе анализа. Важно сохранять результаты для дальнейшей аналитики, отчетов и построения дашбордов.

| Инструменты | Описание | Преимущества | Примеры использования | Рекомендуемый формат хранения |

|---|---|---|---|---|

| Elasticsearch | Индексирование и быстрый поиск по логам | Высокая скорость поиска, REST API | Интеграция через Flink API | JSON, BSON |

| InfluxDB | Хранение временных рядов | Высокая производительность для временных данных | Графики, аналитика | Line Protocol |

Практические рекомендации по построению системы логирования на базе Flink

Создавать систему анализа логов — это не только подключить Flink и настроить брокеры сообщений. Важно продумать архитектуру, обеспечить масштабируемость и безопасность. В этом разделе мы дадим вам практические советы, которые помогут избежать распространенных ошибок.

Что важно учитывать при разработке паттернов обработки логов?

- Планировать схему данных: структурированные лог файлы с четкими типами и полями.

- Обеспечить безопасность данных и авторизацию доступа.

- Использовать схему с временными метками и механизмом кафка-блокировок.

- Настроить резервное копирование и восстановление.

- Использовать тестовые окружения для отработки новых паттернов и функций.

Типичные ошибки и как их избегать

- Недостаточная масштабируемость — планировать систему с запасом по ёмкости и расчетной нагрузке.

- Плохая обработка ошибок, реализовывать тщательное логирование ошибок и автоматическое восстановление.

- Задержки при обработке — оптимизировать код, использовать эффективные алгоритмы и правильно настроить окна обработки.

Подробнее

| Логирование системы Flink | Использование систем логирования для мониторинга обработки потоков данных. Важно настроить сбор логов и анализ ошибок. | JMX, SLF4J | Для диагностики и устранения проблем в реальном времени | ELK Stack, Grafana |

| Интеграция Flink с Kafka и Elasticsearch | Обеспечивает надежную передачу данных и их индексирование для быстрого поиска и аналитики | Kafka Connect, Flink Elasticsearch Sink | Реализация системы логирования в реальном времени | Elasticsearch, Kafka |

| Использование ML для обработки логов | Построение моделей машинного обучения для определения аномалий и прогнозирования | Flink ML, интеграция с сторонними сервисами | Автоматизация аналитики и снижение человеческого фактора | Модели на базе TensorFlow, Scikit-learn |