- Погружение в мир обработки больших файлов: как эффективно управлять огромными объемами данных

- Особенности работы с большими файлами: что важно знать

- Ключевые паттерны для обработки больших файлов

- Потоковая обработка (Streaming)

- Плюсы и минусы поточной обработки

- Разделяй и властвуй (Divide and Conquer)

- Логика алгоритма внешней сортировки

- Плюсы и минусы метода

- Использование очередей и буферов (Queue and Buffer)

- Преимущества и недостатки

- Параллельная обработка (Parallel Processing)

- Ключевые особенности реализации

- Многоуровневая обработка (Multi-stage Processing)

- Плюсы и минусы

- Платформы и инструменты для работы с большими файлами

- Практический опыт: наш путь к эффективной обработке данных

Погружение в мир обработки больших файлов: как эффективно управлять огромными объемами данных

Когда мы сталкиваемся с задачей обработки больших файлов, перед нами зачастую возникает много вопросов: с чего начать, какие инструменты выбрать, как обеспечить надежность и скорость выполнения операций. В нашей статье мы расскажем о лучших паттернах и практиках для работы с массивными объемами данных, поделимся личным опытом и практическими советами, которые помогут вам стать настоящими мастерами в данной области.

Особенности работы с большими файлами: что важно знать

Обработка больших файлов — задача, требующая особого подхода. В отличие от работы с малыми файлами, где всё можно загрузить целиком в память, большие объемы данных требуют разбиения процесса на части, оптимизированных алгоритмов и аккуратной работы с ресурсами системы. Важно учитывать такие факторы, как:

- Объем оперативной памяти — современные компьютеры редко способны загружать в память полностью многгигабайтные файлы. Нужно искать решения для потоковой обработки.

- Время выполнения — для больших данных важно обеспечить минимальное время обработки или сделать её прогнозируемой.

- Использование ресурсов — избегайте ситуаций, когда один процесс загружает всю систему, мешая другим задачам.

- Надежность и отказоустойчивость, большие операции могут прерываться. Отслеживайте прогресс, сохраняйте промежуточные результаты.

Эти особенности диктуют необходимость использовать паттерны, позволяющие эффективно управлять большими файлами, снижать нагрузку на ресурсы и повышать надежность процессов.

Ключевые паттерны для обработки больших файлов

Всем, кто сталкивался с tarefaми обработки огромных данных, хорошо знакомы такие паттерны:

- Паттерн «Потоковая обработка» (Streaming)

- Паттерн «Разделяй и властвуй» (Divide and Conquer)

- Паттерн «Использование очередей и буферов» (Queue and Buffer)

- Паттерн «Параллельная обработка» (Parallel Processing)

- Паттерн «Многоуровневая обработка» (Multi-stage Processing)

Потоковая обработка (Streaming)

Этот паттерн — основа для работы с файлами, которые не помещаются в память целиком. Вместо попытки загрузить весь файл, мы читаем его по частям, обрабатывая каждую порцию по мере необходимости. Такой подход позволяет значительно снизить требования к системе и обеспечить постоянную обработку даже очень больших данных.

На практике это реализуется с помощью потоков, буферов и снифферов данных. В языке Python, например, для чтения больших файлов используют конструкцию with open(filename, 'r') as file:, далее читают порциями:

chunk_size = 1024 * 1024 # 1 МБ

with open('bigfile.txt', 'r') as file:

while True:

data = file.read(chunk_size)

if not data:

break

process(data)

Ключевое преимущество этого метода, экономия ресурсов и возможность обработки файла даже при ограниченной памяти.

Плюсы и минусы поточной обработки

| Плюсы | Минусы |

|---|---|

| Экономия памяти | Сложность управления состоянием обработки |

| Простая реализация в большинстве языков | Можно столкнуться с фрагментацией данных |

Разделяй и властвуй (Divide and Conquer)

Этот паттерн предполагает разбиение файла на части, их обработку независимо друг от друга, а затем объединение результатов. Особенно хорошо подходит для анализа, поиска и сортировки огромных массивов данных.

Принцип прост: файл разбивается на сегменты, обработка каждого сегмента осуществляется параллельно, а итоговые результаты собираются на финальной стадии. Например, сортировка файла в несколько этапов с помощью алгоритма внешней сортировки (external sort) — классический пример.

Пример: при обработке огромного файла логов можно разбивать его на куски по нескольку гигабайт, сортировать каждый сегмент в отдельном процессе или потоках, затем склеить результаты в итоговый упорядоченный файл.

Логика алгоритма внешней сортировки

| Этап | Описание |

|---|---|

| Разделение файла | Разделение файла на управляемые блоки |

| Локальная сортировка | Обработка каждого блока отдельно, сортировка |

| Слияние сегментов | Объединение отсортированных частей в итоговую упорядоченную структуру |

Плюсы и минусы метода

- Плюсы: возможность обработки очень больших данных, минимальное использование оперативной памяти.

- Минусы: усложнение логики, необходимость дополнительных ресурсов для слияния.

Использование очередей и буферов (Queue and Buffer)

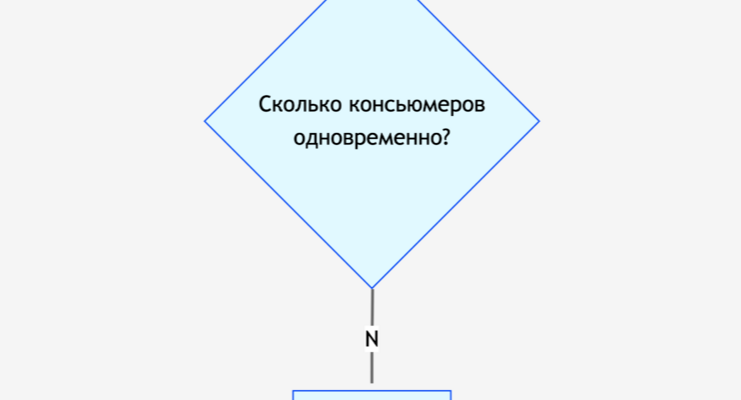

Для эффективной обработки больших потоков данных критически важно управлять буферами и очередями. Этот паттерн помогает сгладить разрывы скоростей между производителем данных и их потребителем, снизить задержки и обеспечить стабильную работу системы.

Практический пример — при сборе логов или данных с нескольких источников. Используют очереди (queue.Queue в Python или подобные конструкции в других языках), в которые поступают данные, а из них затем они обрабатываются по мере необходимости.

Это особенно важно при реализации многопоточных или распределенных систем, где потоки данных приходят асинхронно, а их обработка должна быть синхронизирована для не допущения потери информации.

Преимущества и недостатки

| Плюсы | Минусы |

|---|---|

| Гибкость и масштабируемость | Может потребовать сложной синхронизации |

| Обеспечивает асинхронность и отказоустойчивость | Дополнительная сложность внедрения |

Параллельная обработка (Parallel Processing)

Параллельный режим — один из наиболее мощных инструментов для работы с большими файлами. За счет разделения задач на несколько потоков или процессов достигается значительное ускорение выполнения. В современном мире этот паттерн стал почти стандартом при работе с объемными данными.

Использование многоядерных процессоров и технологий многопоточности дает возможность одновременно обрабатывать разные части файла. В Python для этого используют модули multiprocessing, в Java — ExecutorService, в C++ — OpenMP и другие.

| Плюсы | Минусы |

|---|---|

| Ускорение обработки данных | Сложность синхронизации и управления потоками |

| Оптимизация использования ядер процессора | Потребление дополнительных ресурсов |

Ключевые особенности реализации

- Разделение файла на части, обрабатываемые параллельно

- Обмен результатами через очереди или общие хранилища

- Обеспечение синхронности и целостности данных

Многоуровневая обработка (Multi-stage Processing)

Этот паттерн предполагает разбитие сложных операций на последовательность независимых этапов, каждый из которых обрабатывает данные и передает их дальше. Такой подход позволяет масштабировать и балансировать нагрузку, а также управлять сложностью системы.

Пример — при обработке больших данных для машинного обучения — сначала происходит очистка, потом трансформация, затем выбор признаков и финальное моделирование. Разделение по этапам облегчает отладку и расширение системы.

Плюсы и минусы

| Плюсы | Минусы |

|---|---|

| Гибкая масштабируемость | Может увеличивать сложность архитектуры |

| Легче отслеживать ошибки | Нужно управлять состоянием каждого этапа |

Платформы и инструменты для работы с большими файлами

Для реализации вышеописанных паттернов существует широкий спектр инструментов и платформ. Выбор зависит от конкретных задач, масштаба и требований к скорости и надежности.

| Инструмент / Платформа | Описание | Ключевые особенности |

|---|---|---|

| Apache Hadoop | Распределенная платформа для обработки больших данных | Масштабируемость, отказоустойчивость, MapReduce |

| Apache Spark | Быстрая обработка больших данных, в памяти | Парallel, стриминг, машинное обучение |

| Dask | Параллельные вычисления в Python | Интеграция с NumPy, Pandas, масштабируемость |

| Kafka |