- Погружение в Мир HDFS: Основные паттерны для эффективной работы с распределенной файловой системой

- Что такое паттерны в контексте HDFS?

- Основные паттерны для работы с HDFS

- Распределенная репликация данных

- Ключевые моменты:

- Балансировка нагрузки

- Практические рекомендации:

- Архитектура с шардингом (Sharding)

- Использование сжатия и дедупликации

- Практические советы:

- Использование MapReduce и других фреймворков

- Практическое применение паттернов: кейсы и рекомендации

Погружение в Мир HDFS: Основные паттерны для эффективной работы с распределенной файловой системой

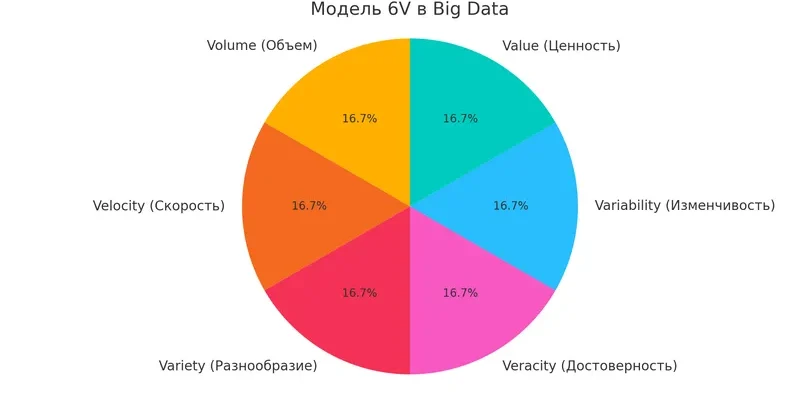

В современном мире больших данных, распределенные системы хранения информации занимают ключевую роль в обеспечении скорости, надежности и масштабируемости бизнес-решений. Одним из наиболее популярных решений для хранения огромных объемов данных является Hadoop Distributed File System (HDFS). Работая с этой системой, важно знать определенные паттерны, которые позволяют оптимизировать работу, повысить надежность и обеспечить эффективное управление данными. В этой статье мы подробно разберем основные паттерны, применяемые при работе с HDFS, их особенности и практическое использование.

Что такое паттерны в контексте HDFS?

Паттерны — это повторяющиеся решения или набор практических правил, которые помогают решать типичные задачи при работе с HDFS. Использование правильных паттернов позволяет снизить риски ошибок, повысить надежность системы и обеспечить удобство в управлении данными.

Важно понимать, что паттерны не являются жесткими шаблонами. Они — скорее рекомендации, которые могут адаптироваться под конкретные задачи, поддерживая гибкую и масштабируемую работу.

Основные паттерны для работы с HDFS

Распределенная репликация данных

Это один из наиболее фундаментальных паттернов. Он предполагает автоматическое создание копий данных на разных дата-нодах, что обеспечивает отказоустойчивость и доступность информации.

Ключевые моменты:

- Резервное копирование позволяет обеспечить сохранность данных при аппаратных сбоях.

- Количество реплик настраивается в зависимости от требований к надежности и ресурсов.

- Пример: Обычно рекомендуется устанавливать не менее 3 реплик для критичных данных.

| Параметр | Описание |

|---|---|

| replication factor | Количество копий файла в системе. |

| failover | Автоматическое переключение при сбое данных. |

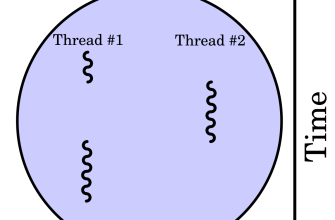

Балансировка нагрузки

Для эффективной работы кластера необходимо равномерное распределение данных и запросов. Паттерн балансировки включает использование стратегий, поддерживающих равномерную загрузку всех узлов.

Практические рекомендации:

- Настраивайте параметры распределения данных при загрузке.

- Используйте средства мониторинга для анализа узлов.

- Обеспечьте автоматическую миграцию данных при необходимости.

Архитектура с шардингом (Sharding)

Данный паттерн подразумевает разбивку больших объемов данных на независимые сегменты, которые хранятся на разных узлах. Это увеличивает скорость доступ к отдельным частям данных и позволяет масштабировать систему.

| Параметр | Значение |

|---|---|

| Shard size | Определяет минимальный размер сегмента |

| Shard key | Ключ, по которому осуществляется разбивка данных |

| Распределение | Равномерное или специальное для определенных данных |

Использование сжатия и дедупликации

Эффективное использование паттернов сжатия и дедупликации данных помогает снизить занимаемое место, ускоряет процессы чтения и уменьшает нагрузку на сеть и дисковую подсистему.

Практические советы:

- Выбирайте подходящие форматы сжатия (например, Snappy, Zlib).

- Автоматизируйте процесс дедупликации при загрузке данных.

- Комбинируйте эти паттерны для достижения максимальной эффективности.

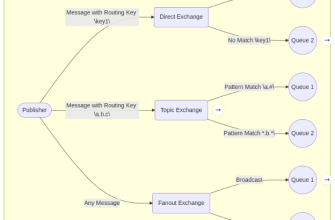

Использование MapReduce и других фреймворков

Для обработки больших данных в HDFS активно используют паттерн интеграции с фреймворками типа MapReduce, Spark или Flink. Он позволяет выполнять распределенные вычисления без необходимости выгрузки данных в другие системы.

| Особенности | Преимущества |

|---|---|

| Обработка на месте | Минимальные затраты на перемещение данных |

| Масштабируемость | Обработка увеличивающихся объемов данных |

| Интеграция | Поддержка различных фреймворков |

Практическое применение паттернов: кейсы и рекомендации

Работа с HDFS — это не только о технических аспектах, но и о правильной организации процессов хранения, обработки и восстановления данных. Следующие рекомендации помогут вам внедрить паттерны в реальную деятельность:

- Анализ требований к надежности для выбора количества реплик и резервных копий.

- Мониторинг состояния системы для своевременного реагирования на перегрузки и сбои.

- Автоматизация процессов балансировки и миграции данных.

- Обучение команды работе с паттернами и особенностями HDFS.

- Планирование масштабируемости при росте объемов данных.

Работа с HDFS предлагает огромные возможности для хранения и обработки данных. Однако без использования проверенных паттернов эффективность и надежность работы могут снизиться. Важно не только знать основные практики, такие как репликация, шардирование, балансировка, сжатие и интеграция с фреймворками, но и уметь адаптировать их под свои конкретные задачи.

Мы надеемся, что данное руководство поможет вам лучше понять, как выстроить работу с HDFS для достижения максимальных результатов и обеспечить своему бизнесу устойчивое развитие в условиях современных вызовов Big Data.

Вопрос: Какие основные паттерны существуют для повышения надежности и эффективности работы с HDFS?

Подробнее

| HDFS репликация данных | Балансировка нагрузки в Hadoop | Шардирование в HDFS | Сжатие данных в Hadoop | Интеграция с MapReduce |

| Дедупликация данных | Масштабирование HDFS | Monitoring Hadoop | Настройка повторной репликации | Оптимизация работы с большими данными |