- Погружаемся в мир Kafka: паттерны и лучшие практики для эффективной работы

- Что такое паттерны в работе с Kafka?

- Ключевые паттерны для работы с Kafka

- Разделение по ключам (Partitioning)

- Репликация и отказоустойчивость (Replication)

- Паттерн "Event Sourcing"

- Kafka Connect — автоматизация интеграций

- Паттерн "Streaming ETL"

- Лучшие практики при работе с Kafka

Погружаемся в мир Kafka: паттерны и лучшие практики для эффективной работы

В современном мире обработки данных‚ где скорость и надежность имеют первостепенное значение‚ Apache Kafka занимает уникальное место как распределенная платформа потоковой передачи данных․ Мы часто сталкиваемся с вопросом: как правильно проектировать системы на базе Kafka‚ чтобы обеспечить их масштабируемость‚ отказоустойчивость и эффективность? В этой статье мы подробно разберем основные паттерны работы с Kafka‚ а также поделимся лучшими практиками‚ которые помогут вам создавать надежные и масштабируемые решения․

Вопрос: Какие основные паттерны для работы с Kafka позволяют повысить отказоустойчивость и масштабируемость системы?

Ответ: Основные паттерны включают использование разделения тем по ключам‚ репликацию данных‚ паттерн "Event Sourcing"‚ использование Kafka Connect для интеграции‚ а также паттерн "Streaming ETL"․ Эти подходы помогают обеспечить баланс нагрузки‚ повышение отказоустойчивости системы и удобство обработки потоковых данных․

Что такое паттерны в работе с Kafka?

Паттерны, это проверенные решения и шаблоны проектирования‚ которые помогают разработчикам организовать работу Kafka максимально эффективно․ Они позволяют стандартизировать подходы к обработке данных‚ обеспечивая лучшие показатели по скорости‚ надежности и удобству сопровождения систем․ Каждый паттерн решает определенные задачи‚ связанные с организацией потоковых данных‚ обработкой ошибок‚ масштабированием и интеграцией с другими системами․

Ключевые паттерны для работы с Kafka

Рассмотрим наиболее популярные и эффективные паттерны‚ которые широко используются в современных системах․

Разделение по ключам (Partitioning)

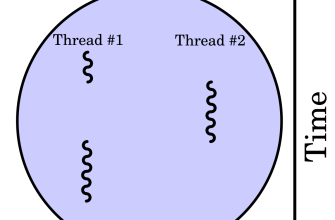

Один из важнейших паттернов — это реализация разделения данных по ключам‚ что позволяет обеспечить равномерное распределение нагрузки между партициями․ Такой подход делает обработку более параллельной и масштабируемой․

| Плюсы | Минусы |

|---|---|

| Повышенная параллельность | Требует продуманного выбора ключей |

| Равномерное распределение данных | Может усложнить обработку уникальных запросов |

Использование ключей позволяет обеспечить‚ чтобы данные‚ связанные одной логикой‚ попадали в одну партицию‚ что повышает эффективность обработки и уменьшает задержки․

Репликация и отказоустойчивость (Replication)

Репликация данных — это неотъемлемая часть надежных систем․ Kafka хранит каждую партицию с несколькими репликами‚ что обеспечивает сохранность данных даже при сбое отдельных брокеров․

- Минимальный уровень репликации: указывается при создании темы‚ обычно это 2 или 3 копии․

- Автоматическая синхронизация: Kafka обеспечивает автоматическую репликацию и согласование данных․

Таблица 1․ Особенности репликации:

| Параметр | Описание |

|---|---|

| min․insync․replicas | Минимальное число реплик‚ подтверждающих запись |

| acks | Параметр подтверждения записи |

Паттерн "Event Sourcing"

Этот паттерн предполагает хранение всех событий системы в потоке Kafka‚ что позволяет восстановить состояние системы в любой момент времени или анализировать историю изменений․

- Плюсы: простое отслеживание истории‚ возможность репликации состояния․

- Минусы: необходимость в обработке большого объема данных‚ что может требовать дополнительных ресурсов․

Пример: использование Kafka для хранения всех изменений в системе управления заказами — каждое добавление‚ обновление или удаление — фиксируется как отдельное событие․

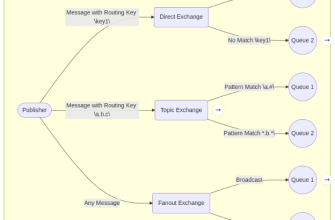

Kafka Connect — автоматизация интеграций

Kafka Connect — это инструмент для соединения Kafka с внешними системами (базами данных‚ хранилищами‚ файлами) без написания кастомного кода․

- Source Connectors: собирают данные из внешних систем в Kafka․

- Sink Connectors: выгружают данные из Kafka в целевые системы․

Стандартные коннекторы позволяют автоматизировать процессы ETL‚ упрощая архитектуру и ускоряя развертывание решений․

Паттерн "Streaming ETL"

Обработка потоковых данных в реальном времени с помощью Kafka Streams или Kafka Connect позволяет создавать потоковые пайплайны для преобразования‚ фильтрации и агрегации данных․

- Извлечение данных из источника․

- Преобразование данных в требуемый формат․

- Загрузка готовых данных в хранилище или аналитическую систему․

Этот паттерн помогает реализовать аналитически-ориентированные решения и обеспечивает эффективность обработки больших потоков данных․

Лучшие практики при работе с Kafka

Для достижения максимальной эффективности рекомендуется придерживаться следующих рекомендаций:

- Настройка репликации и минимальных офлайн-реплик для повышения отказоустойчивости․

- Использование ключей для партиционирования данных‚ чтобы обеспечить равномерное распределение нагрузки․

- Мониторинг Kafka с помощью инструментов Prometheus‚ Grafana и Kafka manager․

- Настройка логирования и алертинг для своевременного обнаружения проблем․

- Обеспечение безопасности через шифрование‚ аутентификацию и авторизацию․

Работа с Kafka требует не только знания его внутренней архитектуры‚ но и правильного применения паттернов и практик‚ которые обеспечивают надежность‚ масштабируемость и эффективность системы․ Используя описанные в статье паттерны‚ мы можем проектировать решения‚ способные справляться с большими объемами данных и высоким уровнем нагрузки‚ а также обеспечивать гибкость и расширяемость архитектуры․

Подробнее

| Kafka паттерны для больших данных | Kafka репликация и отказоустойчивость | Kafka Partitioning и ключи | Kafka Connect для интеграции | Event Sourcing с Kafka |

| Kafka streaming ETL | Настройка Kafka для высокой нагрузки | Лучшие практики Kafka | Мониторинг Kafka | Безопасность Kafka |