- Паттерны обработки логов в Apache Spark: секреты эффективности и оптимизации

- Почему важно правильно обрабатывать логи в Spark

- Общие паттерны обработки логов для Spark

- Стандартизация формата логов

- Централизованное хранение логов

- Фильтрация и выделение важных сообщений

- Временная сегментация логов

- Автоматизация обработки и регулярные проверки

- Практический пример: настройка паттерна для логов Spark с помощью ELK-стека

- Шаги реализации

- Ошибки и сложности при внедрении систем логирования в Spark

Паттерны обработки логов в Apache Spark: секреты эффективности и оптимизации

Когда мы сталкиваемся с анализом огромных объемов данных, к таким системам, как Apache Spark, возникают особые требования к сбору, обработке и анализу логов. Логи — это сердце мониторинга любой крупной системы: именно в них раскрываются ошибки, выявляются узкие места, а также отслеживаются ключевые показатели производительности. Однако, большинство специалистов сталкиваются с проблемой — как правильно структурировать и анализировать логи для максимально быстрой и точной диагностики?

В этой статье мы разберем основные паттерны и подходы к обработке логов в Spark, поделимся опытом, расскажем о наиболее применимых инструментах и стратегиях. Наша цель, помочь вам понять, как строить гибкие и эффективные системы логирования, чтобы ваш анализ оставался точным и своевременным, а внедрение автоматических паттернов не требовало больших усилий.

Почему важно правильно обрабатывать логи в Spark

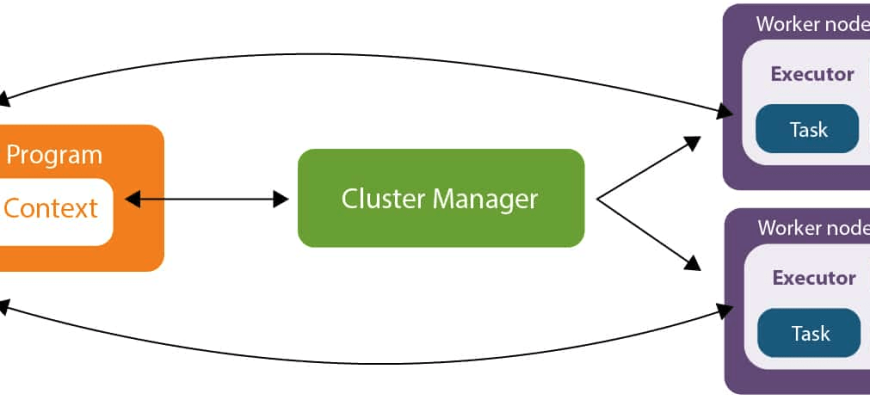

Apache Spark — это платформа для обработки больших данных в реальном времени и пакетных режимах. В процессе работы она генерирует огромное количество логов: сообщения о выполнении задач, ошибки, предупреждения, статусные обновления и многое другое. Правильная обработка и структурирование этих логов позволяют:

- Обеспечить своевременную диагностику ошибок — выявлять сбои на ранних стадиях и минимизировать время простоя.

- Оптимизировать производительность — понять, какие операции тормозят выполнение, и устранить их.

- Создавать автоматические системы оповещения — настроить триггеры для критичных ошибок или аномалий.

- Обеспечить аналитические выводы, использовать логи для построения KPI и мониторинга работы системы.

Чтобы достичь этих целей, необходимо внедрить проверенные паттерны для систематической обработки логов, которые облегчают их анализ и позволяют автоматизировать рутинные задачи.

Общие паттерны обработки логов для Spark

В процессе работы с логами в Spark можно выделить несколько классических паттернов, которые подходят почти для любой крупной системы или проекта. Сейчас мы их подробно разберем, выделим особенности и рекомендации по реализации.

Стандартизация формата логов

Одним из первых шагов является стандартизация формата логов. Это обеспечивает единообразие и упрощает автоматическую обработку. В большинстве случаев рекомендуется использовать структурированные форматы, такие как JSON или CSV, чтобы каждая запись содержала необходимый набор полей — время, уровень логирования, источник, сообщение и дополнительные метаданные.

| Параметр | Рекомендации |

|---|---|

| Время | Используйте универсальный формат времени, например ISO 8601, для легкого сравнения и сортировки |

| Уровень логирования | INFO, WARN, ERROR, DEBUG — для быстрой фильтрации важной информации |

| Источник | Название компонента или модуля, например, Spark Driver или Executor |

| Сообщение | Подробное описание события или ошибки |

| Доп. метаданные | ID задания, номер стадии, имя пользователя, параметры запуска |

Централизованное хранение логов

Для больших систем крайне важно использовать систему централизованного хранения логов — такие решения, как ELK-стек (Elasticsearch, Logstash, Kibana) или аналоги, например, Graylog или Splunk. Такой подход позволяет:

- Обеспечить быстрый доступ к логам из любого места

- Автоматизировать сбор и агрегацию данных от всех компонентов системы

- Настраивать визуализации и дашборды для быстрого мониторинга и анализа

- Вести поиск по логам по различным метрикам и условиям

Если у вас еще нет системы централизованного хранения, рекомендуем начать с простых решений, постепенно наращивая функциональность и автоматизацию.

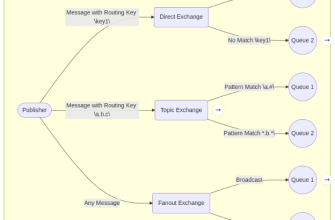

Фильтрация и выделение важных сообщений

Обработка логов требует фильтрации. Не все сообщения имеют одинаковую важность или требуют одинакового внимания. В большинстве случаев разумно разделять логи по уровням критичности и выделять приоритетные сообщения, такие как ошибки и предупреждения.

| Категория | Описание |

|---|---|

| Ошибки (Error) | Критические сбои, требующие немедленного вмешательства |

| Предупреждения (Warning) | Возможные проблемы, которые требуют мониторинга |

| Информационные сообщения (Info) | Статус выполнения, прогресс задач |

| Отладочные сообщения (Debug) | Подробные сведения для анализа и тестирования |

Эффективные паттерны предусматривают автоматический фильтр для выделения ошибок и аномалий — например, с помощью регулярных выражений или парсинга JSON, а также интеграцию с системами alerting.

Временная сегментация логов

Когда логов становится очень много, их обработка по одному файлу или записи становится неэффективной. Поэтому важным паттерном является внедрение сегментации логов по времени — создание логов по дням, неделям или даже часам. Это позволяет быстро сузить анализ к определенным промежуткам и ускорить диагностику.

- Автоматическая архивация старых логов

- Использование индексов для быстрых запросов по времени

Большинство систем хранения логов позволяют настроить автоматическую сегментацию и индексирование — используйте эти инструменты максимально эффективно.

Автоматизация обработки и регулярные проверки

Ручная работа при больших объемах логов — источник ошибок и потери времени. Поэтому так важна автоматизация:

- Настройка регулярных задач по очистке и архивированию логов

- Использование скриптов и триггеров для подсветки ошибок

- Создание дашбордов и автоматических отчетов

Инструменты вроде cron, Kafka, Spark Streaming отлично подходят для реализации таких паттернов, позволяя системе самостоятельно реагировать на критические события и сохранять важные метрики.

Практический пример: настройка паттерна для логов Spark с помощью ELK-стека

Рассмотрим пример, как можно реализовать один из паттернов обработки логов — централизованное хранение со структурированными логами и дашбордами на базе ELK-стека:

Шаги реализации

- Настройка логирования Spark: включить вывод логов в JSON-формат для упрощения парсинга

- Настройка Logstash для получения логов и их парсинга в Elasticsearch

- Создание индексов и шаблонов данных

- Настройка Kibana для построения дашбордов — отслеживание ошибок, уровня загрузки, времени выполнения задач

Такой подход позволяет быстро находить проблемные узлы и запускать автоматические проверки — все в одном интерфейсе.

Ошибки и сложности при внедрении систем логирования в Spark

Несмотря на очевидные преимущества, внедрение систем логирования не обходится без трудностей. Часто встречаются ситуации, когда:

- Объем логов становится огромным, необходимы мощные решения для хранения и поиска

- Стандартизация формата требует времени и усилий, особенно в уже существующих системах

- Интеграция с существующими инструментами вызывает сложности, особенно при использовании устаревших решений

- Автоматизация требует внимательного планирования и регулярного контроля

Тем не менее, правильный подход, тестирование и постепенное внедрение позволят минимизировать эти риски и получить все преимущества от современных паттернов обработки логов.

Обработка логов — это неотъемлемая часть успешной работы с большими данными в Apache Spark. Правильные паттерны структурирования, хранения, фильтрации и автоматизации не только значительно упрощают диагностику и мониторинг, но и позволяют повысить эффективность всей системы в целом. Все рекомендации, которые мы рассмотрели, можно адаптировать под любые требования — от небольших проектов до корпоративных решений.

Главное — помните, что системный подход и автоматизация превращают сложные потоки данных в управляемую и прозрачную инфраструктуру. И чем лучше вы будете знать свои логи, тем быстрее сможете реагировать на любые изменения и кризисы в системе.

Вопрос: Какие основные паттерны при обработке логов в Spark помогут повысить эффективность мониторинга и диагностики?

Ответ заключается в стандартизации формата логов, централизованном хранении, фильтрации по важности, временной сегментации и автоматизации обработки. Эти паттерны позволяют быстро находить ошибки, строить информативные дашборды и автоматические системы оповещения, что значительно повышает эффективность мониторинга и диагностики системы.

Подробнее

| Обработка логов Spark | Стандартизация логов в Spark | Централизованное хранение логов | Автоматизация логов Spark | ELK-стек в анализе логов |

| Фильтрация логов Spark | Инструменты мониторинга Spark | Аналитика по логам в Spark | Ошибки обработки логов | Реализация автоматических алертов |

| Временная сегментация логов | Регулярные проверки логов | Анализ ошибок Spark | Логи и метрики Spark | Настройка Kibana для Spark |

| Лучшие практики логирования | Обработка ошибок Spark | Форматы логов Spark | Интеграция Spark и ELK | Оптимизация логов Spark |