- Паттерны обработки логов Spark: Как сделать работу с данными проще и эффективнее

- Что такое логирование в Spark и зачем оно нужно?

- Основные паттерны обработки логов Spark

- Использование регулярных выражений для парсинга логов

- Использование структурированных форматов логов (JSON, Parquet)

- Паттерн потоковой обработки (Streaming logs)

- Подробнее о потоковой обработке:

- Практические рекомендации по реализации паттернов

- Таблица рекомендаций по паттернам обработки логов

- Подробнее

Паттерны обработки логов Spark: Как сделать работу с данными проще и эффективнее

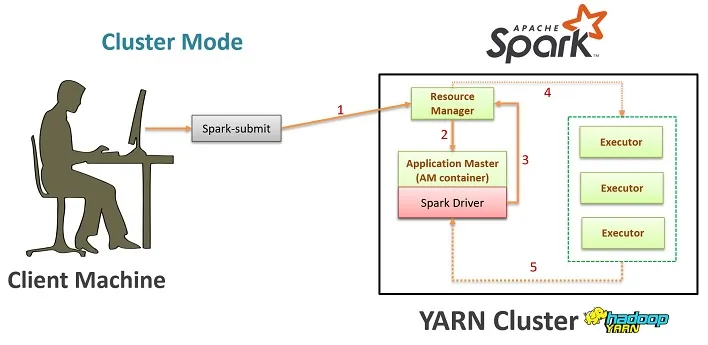

В современном мире обработки больших данных Spark занимает важнейшее место․ Особенно актуальной становится задача автоматизации и оптимизации процесса анализа логов, которые генерируются при выполнении различных задач․ В этой статье мы подробно разберем основные паттерны и подходы для обработки логов Spark, поделимся практическими советами и лучшими практиками, чтобы ваш рабочий процесс стал более эффективным и понятным․

Что такое логирование в Spark и зачем оно нужно?

Логирование — это систематический сбор информации о состоянии системы, выполнении задач, ошибках и других событиях, происходящих во время работы Spark․ Чем лучше организовано логирование, тем проще диагностировать проблемы, выявлять узкие места и совершенствовать производительность․

Логи могут содержать как техническую информацию, такую как время выполнения операций, нагрузка на ресурсы, ошибки и исключения, так и бизнес-метрики, что очень важно для мониторинга процесса и анализа эффективности работы системы․

Вопрос: Почему правильно организованное логирование важно при обработке данных в Spark?

Ответ: Правильно организованное логирование позволяет быстро обнаружить и устранить ошибки, понять причины задержек и повысить общую производительность системы․ Это помогает оптимизировать процессы, снизить время выяснения причин неполадок и обеспечить стабильную работу аналитических задач․

Основные паттерны обработки логов Spark

Рассматривая обработку логов Spark, важно понять основные паттерны, которые позволяют автоматизировать и упростить работу с большими объемами данных․ Ниже приведены наиболее часто используемые подходы и архитектурные решения․

Использование регулярных выражений для парсинга логов

Один из наиболее популярных методов — использование регулярных выражений (regex); Этот паттерн позволяет быстро извлекать актуальную информацию из логов, такие как временные метки, уровни логирования, идентификаторы задач, сообщения и ошибки․

Пример простого regex для извлечения временной метки и уровня логирования:

import re log_line = "2024-04-27 15:30:45 INFO Task completed successfully" pattern = r"(?P\d{4}-\d{2}-\d{2} \d{2}:\d{2}:\d{2}) (?P \w+) (?P ․+)" match = re․match(pattern, log_line) if match: print(match․group('timestamp')) # 2024-04-27 15:30:45 print(match․group('level')) # INFO

Преимущество этого паттерна — его универсальность и возможность адаптации под разные форматы логов․ Однако важен правильный подбор регулярных выражений, чтобы обеспечить точность извлечения данных․

Использование структурированных форматов логов (JSON, Parquet)

Еще один важный паттерн — организация логов в структурированные форматы, такие как JSON или Parquet․ Это значительно упрощает последующую обработку данных в Spark, поскольку структура заранее определена и легко читается․

Преимущества структурированных логов:

- Легкость парсинга — можно просто читать как таблицу․

- Более высокая скорость обработки — благодаря схеме данных․

- Меньше ошибок — исключается неправильная интерпретация данных․

Пример использования JSON:

{

"timestamp": "2024-04-27T15:30:45",

"level": "INFO",

"taskId": "12345",

"message": "Job completed"

}

Обработка таких логов в Spark сводится к чтению JSON через встроенные функции:

val logsDF = spark․read․json("path/to/logs․json")

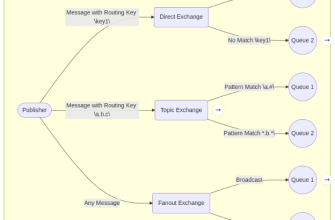

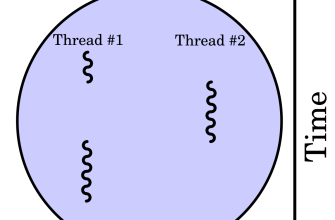

Паттерн потоковой обработки (Streaming logs)

Использование паттерна потоковой обработки позволяет анализировать логи в реальном времени, получая своевременную информацию о состоянии системы․

Для этого используют Spark Structured Streaming, который позволяет обрабатывать потоковые данные с минимальной задержкой․

Пример базовой конфигурации:

val streamDF = spark․readStream

․format("json")

․schema(schema)

․load("path/to/stream/logs/")

Далее можно писать различные фильтры и агрегаты, чтобы мониторить системные метрики, ошибки или показатели производительности в реальном времени․

Подробнее о потоковой обработке:

- Настройка источников данных — Kafka, файлы или сокеты;

- Обработка данных через Spark Streaming API;

Практические рекомендации по реализации паттернов

Когда мы внедряем те или иные паттерны обработки логов в рабочий проект, важно помнить ряд практических рекомендаций:

- Автоматизация парсинга — создавайте скрипты, которые автоматически собирают и структурируют логи․

- Используйте единую схему — единая структура логов позволяет проще масштабировать решения и интегрировать их с аналитическими системами․

- Настраивайте мониторинг — автоматические уведомления при возникновении ошибок или тревожных метрик․

- Оптимизируйте хранение — используйте форматы Parquet или ORC для хранения исторических логов․

- Обеспечивайте безопасность и конфиденциальность — шифрование логов, контроль доступа и аудит․

Таблица рекомендаций по паттернам обработки логов

| Паттерн | Преимущества | Недостатки | Рекомендуемый случай использования |

|---|---|---|---|

| Регулярные выражения | Гибкость, адаптивность | Медленная обработка при больших объемах | Парсинг нестандартных логов |

| Структурированные форматы | Легкая обработка, скорость | Требует предварительной структуризации | Анализ логов в JSON или Parquet |

| Потоковая обработка | Реальное время, мониторинг | Сложнее настройка и поддержка | Обнаружение ошибок, метрики в реальном времени |

Обработка логов в системе Spark — непрерывный и многоуровневый процесс, который требует внимания к деталям, правильной архитектуры и внедрения новых технологий․ Использование паттернов, которые мы рассмотрели, поможет сделать работу с огромными потоками данных более структурированной, автоматизированной и эффективной․

Главное — всегда помнить о необходимости регулярно обновлять свои подходы, учитывать специфику конкретных задач и не бояться внедрять новые методы анализа․ В результате вы получите инструменты для быстрого реагирования на сбои, повышения стабильности системы и получения ценнейших бизнес-метрик․

Подробнее

10 LSI запросов к статье

| Обработка логов Spark | Паттерны анализа логов Spark | Структурированные логи в Spark | Регулярные выражения для логов | Потоковая обработка Spark |

| Оптимизация логов Spark | Обработка ошибок в Spark | Логирование в больших данных | Мониторинг Spark в реальном времени | Лучшие практики обработки логов |