- Паттерны для работы с большими данными: практическое руководство

- Что такое большие данные?

- Значимость паттернов

- Классификация паттернов для больших данных

- Паттерны хранения данных

- Таблица: Сравнение паттернов хранения данных

- Паттерны обработки данных

- MapReduce Stream Processing Batch Processing

- Таблица: Паттерны обработки данных

- Лучшие практики работы с большими данными

- Сложности при работе с большими данными

- Будущее больших данных

- Размышления и выводы

Паттерны для работы с большими данными: практическое руководство

В мире, где объем данных растет с каждым днем, понимание того, как работать с большими данными, становится критически важным для успешного ведения бизнеса и принятия обоснованных решений. Мы погрузимся в концепцию паттернов для работы с большими данными, обсудим их значимость, а также поделимся опытом и лучшими практиками, которые помогут вам эффективно управлять и анализировать огромные объемы информации.

Что такое большие данные?

Прежде чем углубиться в паттерны, важно понять, что именно представляют собой большие данные. По сути, большие данные характеризуются тремя основными "V": объем (volume), скорость (velocity) и разнообразие (variety). Это означает, что практически любой бизнес может столкнуться с широким спектром структурированных и неструктурированных данных, которые необходимо агрегировать, анализировать и обрабатывать в реальном времени.

Современные технологии позволяют обрабатывать данные с помощью различных инструментов и технологий, таких как Hadoop, Spark и NoSQL базы данных. Понимание того, как правильно применять эти инструменты, может существенно улучшить ваши процессы и повысить их эффективность.

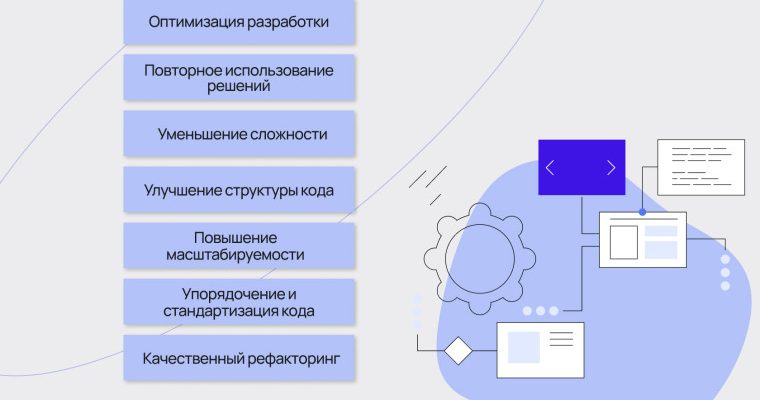

Значимость паттернов

Паттерны для работы с большими данными — это повторяющиеся решения, которые помогают разработчикам и аналитикам справляться с распространенными проблемами. Они являются своего рода руководством, которое помогает избежать ошибок и упрощает процесс разработки.

Применяя паттерны, вы можете значительно сократить время на разработку и оптимизировать вычислительные процессы. В этом контексте важно не только знать, как использовать существующие инструменты, но и знать, когда их применять для достижения наилучших результатов.

Классификация паттернов для больших данных

Паттерны для работы с большими данными можно классифицировать по нескольким критериям. Основные из них включают:

- Паттерны хранения данных

- Паттерны обработки данных

- Паттерны передачи данных

- Паттерны аналитики

Паттерны хранения данных

Паттерны хранения данных определяют, как и где будут храниться большие объемы информации. Одним из самых популярных решений является использование распределенных файловых систем, таких как HDFS (Hadoop Distributed File System). Они обеспечивают надежное и эффективное хранение данных, что особенно важно для больших объемов информации.

Использование NoSQL баз данных, таких как MongoDB и Cassandra, также стало стандартом для хранения неструктурированных данных. Эти базы данных предлагают гибкость и масштабируемость, которые необходимы для работы с динамически меняющимися наборами данных.

Таблица: Сравнение паттернов хранения данных

| Паттерн | Тип данных | Где используется | Преимущества |

|---|---|---|---|

| HDFS | Структурированные/неструктурированные | Аналитические системы | Высокая производительность, доступность |

| MongoDB | Неструктурированные | Веб-приложения | Гибкость, расширяемость |

| Cassandra | Полуструктурированные | Социальные приложения | Масштабируемость, высокая доступность |

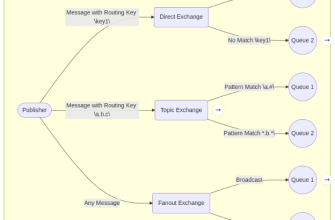

Паттерны обработки данных

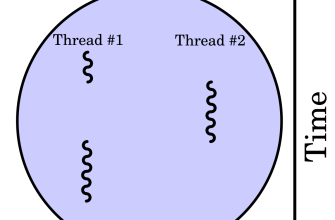

Паттерны обработки данных определяют, как данные будут собираться, обрабатываться и анализироватся. Одним из наиболее распространенных методов является подход "MapReduce", который позволяет разбивать задачу на более мелкие подзадачи, параллельно обрабатывать их и в конечном итоге объединять результаты.

С помощью таких фреймворков, как Apache Storm и Apache Spark, можно выполнять потоковую обработку данных в реальном времени. Эти технологии предлагают высокую производительность и позволяют обрабатывать большие объемы данных мгновенно.

- MapReduce

- Stream Processing

- Batch Processing

Таблица: Паттерны обработки данных

| Паттерн | Тип обработки | Инструменты | Сценарии использования |

|---|---|---|---|

| MapReduce | Пакетная обработка | Hadoop | Анализ больших данных |

| Stream Processing | Потоковая обработка | Apache Storm, Spark Streaming | Обработка данных в реальном времени |

| Batch Processing | Пакетная обработка | Apache Flink | Регулярные задачи анализа |

Лучшие практики работы с большими данными

Мы постоянно изучаем и адаптируем лучшие практики работы с большими данными. Одним из ключевых аспектов является правильное планирование и архитектура. Без должной структуры данные могут привести к заторам и замедлению процессов. Поэтому мы рекомендуем следовать концепции "Data Lake", при которой данные хранятся в своем оригинальном формате и обрабатываются по мере необходимости.

Также стоит обратить внимание на использование метаданных, которые помогут упростить процесс поиска и доступа к данным; Это не только ускоряет анализ, но и повышает общую производительность системы.

Сложности при работе с большими данными

Несмотря на наличие паттернов и технологий, работа с большими данными часто сталкивается с трудностями. Некоторые из них включают в себя проблемы с интеграцией данных, безопасность и конфиденциальность, а также высокую стоимость хранения и обработки данных.

- Интеграция данных из различных источников

- Обеспечение безопасности данных

- Оптимизация стоимости хранения

Будущее больших данных

Перспективы работы с большими данными остаются многообещающими. Мы видим, как постепенно внедряются технологии искусственного интеллекта и машинного обучения в процессы анализа данных — это открывает новые горизонты для более глубокого понимания данных и создания предсказательных моделей.

Важно отметить, что в будущем мы будем больше уделять внимание вопросам этики и соблюдения законов о защите данных. Все эти факторы помогут сформировать более надежные структуры для работы с данными и повысить доверие клиентов.

Размышления и выводы

Какые паттерны наиболее эффективны для работы с большими данными?

Наиболее эффективные паттерны варьируются в зависимости от особенностей бизнеса и данных. Однако, среди самых популярных можно выделить паттерны хранения (например, HDFS и NoSQL базы данных), паттерны обработки (такие как MapReduce и потоковая обработка) и паттерны аналитики. Очевидно, выбор подходящих паттернов может существенно упростить управление данными и повысить их ценность для бизнеса.

Подробнее

| парадигмы работы с данными | аналитика больших данных | инструменты для анализа данных | потоковая обработка данных | будущее больших данных |

| парадигмы хранения данных | методологии работы с данными | шаблоны работы с данными | искусственный интеллект в больших данных | безопасность больших данных |