- Паттерны для обработки логов Spark: эффективные стратегии и практические рекомендации

- Что такое паттерны для обработки логов и зачем они нужны?

- Обзор основных паттернов анализа логов Spark

- Выделение ошибок и исключений

- Мониторинг производительности

- Идентификация узких мест и проблемных узлов

- Создание собственных паттернов обработки логов

- Как создавать эффективные регулярные выражения?

- Пример создания паттерна для поиска ошибок

- Инструменты для автоматической обработки логов Spark

- Преимущества использования ELK Stack

- Практические советы по внедрению паттернов анализа логов

- Что делать, если лог содержит нестандартные сообщения?

- Вопрос:

- Ответ:

- Обратите внимание: дополнительные ресурсы

Паттерны для обработки логов Spark: эффективные стратегии и практические рекомендации

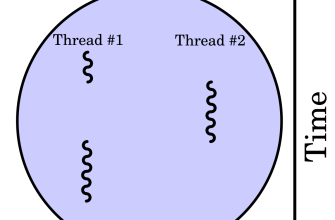

Когда мы начинаем работу с платформой Apache Spark, одна из самых важных задач — это грамотная обработка и анализ логов․ Логи служат мощным инструментом диагностики, оптимизации производительности и устранения ошибок в распараллеленных вычислительных задачах․ Но как правильно структурировать и анализировать логи, чтобы получать максимум информации без лишнего времени и ресурсов? В этой статье мы расскажем о паттернах для обработки логов Spark, поделимся практическими советами и расскажем, как сделать работу с логами более эффективной и понятной․

Что такое паттерны для обработки логов и зачем они нужны?

Паттерны для обработки логов, это заранее продуманные шаблоны, модели или стратегии, которые помогают систематизировать сбор, анализ и интерпретацию логов․ В контексте Spark логов эти паттерны помогают идентифицировать ключевые события, ошибки, предупреждения и показатели производительности․

Использование таких паттернов позволяет:

- ускорить диагностику проблем в кластерных вычислениях;

- систематизировать данные о выполнении задач и узлов;

- автоматизировать часть анализа с помощью регулярных выражений и инструментов;

- улучшить качество мониторинга и отчетности по выполненным заданиям․

Обзор основных паттернов анализа логов Spark

Выделение ошибок и исключений

Первая и, пожалуй, самая важная задача, это быстро находить записи, содержащие ошибки и исключения․ Обычно такие лог-записи содержат определённые паттерны, например, слова ERROR, Exception или tracebacks․

| Параметр | Описание | Пример |

|---|---|---|

| Ошибка | Обнаружение строк с ключевыми словами ERROR или FATAL | ERROR org․apache․spark․․․ |

| Исключение | Обнаружение исключений и стек трейсов | java․lang․NullPointerException |

| Traceback | Обнаружение длинных трассировок стека вызовов | NullPointerException |

Обработка ошибок — это основа любой системы поддержки, и_ правильное использование регулярных выражений (регексов)_ позволяет автоматически фильтровать и группировать сообщение об ошибках․

Мониторинг производительности

Паттерн для отслеживания времени выполнения задач, ресурсов и задержек помогает понять, где возникают узкие места․ В логах Spark записи о времени выполнения обычно содержат KPI (ключевые показатели эффективности), такие как время задачи, время этапа и задержки на стадии․

| Параметр | Описание | Пример |

|---|---|---|

| Время выполнения | Обнаружение строк с длительностью задач | Stage completed in 1200 ms |

| Задержки | Детализация задержек между этапами | Waiting for executor |

| Использование ресурсов | Анализ использования CPU и памяти | Memory metrics: ․․․ |

Идентификация узких мест и проблемных узлов

Обнаружение узких мест в кластере выполняется на основании паттернов, связанных с ошибками соединений, перегрузками или сбоями отдельных узлов․ Логи могут содержать записи вида «Lost executor» или «Node failed», которые свидетельствуют о проблемах на инфраструктурном уровне․

| Ключевые слова | Описание | Пример |

|---|---|---|

| Node failure | Обнаружение ошибок отключения узлов | Lost executor 1234 on node xyz |

| Timeouts | Обнаружение тайм-аутов запросов или задач | TimeoutException |

| Перегрузка ресурса | Записи о превышении лимитов памяти или CPU | OutOfMemoryError |

Создание собственных паттернов обработки логов

Для эффективной обработки логов Spark важно не только использовать стандартные шаблоны, но и создавать собственные паттерны, которые соответствуют конкретным требованиям проекта или инфраструктуре․ Обучение работе с регулярными выражениями — это первый шаг к автоматизации анализа логов․

Как создавать эффективные регулярные выражения?

- Определите ключевые слова или фразы: например, ERROR, WARN, Exception․

- Используйте группы для захвата данных: для извлечения времени, имени файла или класса․

- Тестируйте выражения на небольших выборках логов: чтобы убедиться в точности поиска․

- Автоматизируйте процесс обработки: используя скрипты на Python, Bash или инструменты ELK Stack․

Пример создания паттерна для поиска ошибок

regex = r"ERROR․*?(\d+ ms) / (\w+Error) "Это выражение поможет автоматически находить строки с ошибками и временем их выполнения, что значительно ускоряет анализ логов․

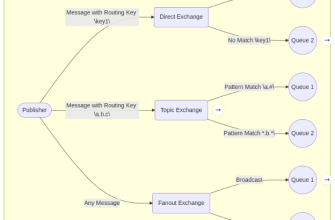

Инструменты для автоматической обработки логов Spark

Для обработки логов на практике используют различные инструменты и платформы․ Среди них:

- ELK Stack (Elasticsearch, Logstash, Kibana): мощное решение для сбора, хранения и визуализации данных логов․

- Splunk: платформа для поиска и анализа логов в реальном времени․

- Apache Flink: для стриминговой обработки логов․

- Custom Scripts: на Python, Bash или PowerShell для обработки логов в автоматическом режиме․

Преимущества использования ELK Stack

| Особенность | Описание | Преимущество |

|---|---|---|

| Автоматический сбор | Интеграция с логами Spark через Logstash | Мгновенная агрегация данных |

| Индексация | Быстрый поиск и фильтрация | Мгновенное выявление ошибок и паттернов |

| Визуализация | Панели в Kibana | Интерактивный анализ KPI и проблем |

Практические советы по внедрению паттернов анализа логов

Создание и внедрение паттернов требует системного подхода․ Ниже представлены ключевые рекомендации, которые помогут сделать этот процесс успешным:

- Начинайте с базовых шаблонов, научитесь быстро находить ошибки и ключевые метрики․

- Автоматизируйте сбор и обработку, используйте скрипты и инструменты․

- Ведите документацию — сохраняйте выбранные паттерны, чтобы их можно было быстро применять в будущем․

- Регулярно обновляйте паттерны — новые виды логов требуют новых стратегий․

- Используйте визуализацию, dashboards и дашборды помогают лучше понять состояние системы․

Что делать, если лог содержит нестандартные сообщения?

Если встречаете нестандартные сообщения или форматы логов, рекомендуется создавать индивидуальные паттерны, основанные на анализе этих сообщений․ В некоторых случаях потребуется писать собственные парсеры или скрипты для структурирования данных․

Обработка логов — это не разовая задача, а постоянный процесс совершенствования․ Создавая эффективные паттерны, автоматизируя сбор и анализ, мы можем значительно повысить производительность работы и снизить время реагирования на проблемы․ Важно не бояться экспериментировать с регулярными выражениями, внедрять новые инструменты и вести системную документацию․ Тогда логика работы с логами станет понятной, прозрачной и максимально полезной для всех участников проекта․

Вопрос:

Какие основные паттерны следует использовать для анализа логов Spark и как их применять на практике?

Ответ:

Основные паттерны включают выявление ошибок и исключений, мониторинг времени выполнения задач, идентификацию узких мест и проблемных узлов․ Практически это реализуеться с помощью регулярных выражений, автоматизированных скриптов и платформ для визуализации, таких как ELK Stack․ Регулярное обновление и систематизация паттернов помогают обеспечить эффективность работы с логами и быстроту реагирования на возникающие проблемы․

Обратите внимание: дополнительные ресурсы

Подробнее

| Обработка логов Spark | Регулярные выражения для логов | Инструменты анализа логов | Автоматизация логов Spark | Мониторинг производительности Spark |

| ELK Stack для логов | Регексы для ошибок | Splunk и Spark | Скрипты парсинга логов | Диагностика узких мест |

| Обработка логов Big Data | Ошибки JVM Spark | Автоматический анализ | Визуализация данных логов | Оптимизация Spark по логам |