- Паттерны для обработки логов с помощью Spark: эффективные техники анализа данных

- Что такое паттерны обработки логов и зачем они нужны?

- Классификация паттернов: основные категории

- Паттерн 1: Фильтрация логов — выделение релевантных данных

- Пример реализации фильтрации с помощью Spark

- Паттерн 2: Агрегация и группировка данных

- Пример агрегации ошибок по времени

- Паттерн 3: Обнаружение аномальных событий

- Пример использования классической модели отклонения

- Паттерн 4: Машинное обучение для прогнозирования и классификации

- Пример использования Spark MLlib для классификации событий

- Паттерн 5: Визуализация и создание Dashboards

Паттерны для обработки логов с помощью Spark: эффективные техники анализа данных

В современном мире большие объемы данных становятся нормой․ Логи — это ценный источник информации, который помогает понять поведение систем, выявить ошибки и повысить эффективность работы инфраструктуры․ Однако обработка и анализ логов требует мощных инструментов, способных справиться с огромным объемом данных в реальном времени или почти в реальном времени․ Одним из таких инструментов является Apache Spark — распределенная платформа, которая позволяет быстро и эффективно обрабатывать большие массивы данных․

Но чтобы максимально использовать возможности Spark при работе с логами, необходимо знать и применять определённые паттерны, шаблоны обработки данных, которые позволяют упростить работу, повысить точность анализа и выявить интересующие нас события и тренды․ В этой статье мы подробно рассмотрим основные паттерны для обработки логов с помощью Spark, разберем их особенности, применение и наглядно покажем, как они помогают нашим бизнес-процессам․

Что такое паттерны обработки логов и зачем они нужны?

Паттерны обработки логов — это шаблоны, стандартизированные подходы и практики, которые применяются при анализе данных, полученных из лог-файлов․ Их использование значительно упрощает идентификацию событий, сбоев, аномалий и трендов в системах․

Основные преимущества применения паттернов в работе с логами:

- Стандартизация анализа — обеспечивает единый подход к обработке и интерпретации данных․

- Ускорение процесса — автоматизация повторяющихся операций помогает сократить время обработки․

- Повышение точности — снижается вероятность ошибок или пропуска важной информации․

- Облегчение масштабирования, упрощает работу при увеличении объема данных или количества логов․

Рассмотрим основные паттерны, которые используют при работе с логами через Spark и почему они считаются ключевыми для аналитиков и DevOps-инженеров․

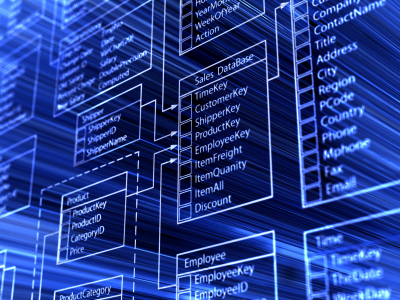

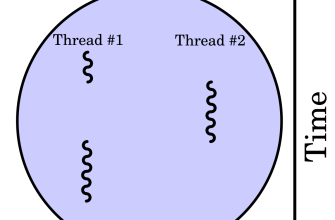

Классификация паттернов: основные категории

Паттерны обработки логов можно условно разделить на несколько категорий, в зависимости от цели и метода реализации․ Основные категории:

- Фильтрация и предварительная обработка — отправка только релевантных логов на последующую обработку․

- Агрегация данных — сбор и объединение информации для выявления трендов и статистики․

- Обнаружение аномалий — выявление необычных событий и отклонений в логах․

- Машинное обучение и предиктивная аналитика — использование ML-моделей для прогнозирования и автоматической классификации событий․

- Интеграция и визуализация, создание dashboards и информационных панелей для быстрого анализа и принятия решений․

В каждом из этих паттернов характерны свои техники реализации с помощью Spark, о которых пойдет речь далее․

Паттерн 1: Фильтрация логов — выделение релевантных данных

Самый первый и важный шаг в обработке логов — это фильтрация․ В системных логах часто содержится огромное количество информации: микросервисы, firewall, системные уведомления, — все это создает шум, который мешает выявить действительно важные события․ Использование Spark позволяет быстро исключить ненужные данные и сосредоточиться на событиях, важных для анализа․

Пример реализации фильтрации с помощью Spark

from pyspark․sql import SparkSession

spark = SparkSession․builder․appName("LogFiltering")․getOrCreate

logs = spark․read․json("hdfs://logs/*;json")

Фильтрация по уровню ошибок

error_logs = logs․filter(logs․level == "ERROR")․filter(logs․timestamp > "2023-10-01")

error_logs․show(5)

Эта простая, но мощная техника позволяет сразу сосредоточиться на критически важной информации, пропуская всё остальное․ Часто комбинируется с другими паттернами для дальнейшего анализа․

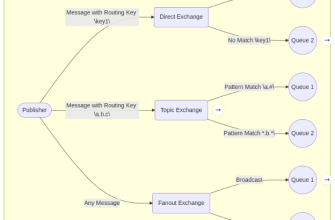

Паттерн 2: Агрегация и группировка данных

Для понимания общего состояния системы или выявления проблемных участков важно собирать статистику по логам․ Агрегация данных — объединение сообщений по ключам, временным промежуткам или типам событий․ Использование Spark SQL и DataFrame API делает этот процесс очень быстрым и масштабируемым․

Пример агрегации ошибок по времени

from pyspark․sql․functions import window, count

Группировка ошибок по часам

error_counts = logs․filter(logs․level == "ERROR")

․groupBy(window(logs․timestamp, "1 hour"))

․agg(count("*")․alias("error_number"))

error_counts․show(5)

Такая обработка помогает определить пиковые часы возникновения ошибок и принять меры по устранению причин․

Паттерн 3: Обнаружение аномальных событий

Одной из самых востребованных задач аналитики логов является автоматическое выявление аномалий․ Эти события могут указывать на сбои, взломы или другие необычные ситуации․ В Spark реализуются различные методы обнаружения аномалий, начиная от простых правил до ML-моделей․

Пример использования классической модели отклонения

from pyspark․ml․stat import Summarizer

from pyspark․sql․functions import mean, stddev

stats = logs․select(

mean("response_time")․alias("avg_response"),

stddev("response_time")․alias("std_response")

)․collect[0]

Обнаружение логов с response_time за пределами 3 стандартных отклонений

threshold_upper = stats['avg_response'] + 3 * stats['std_response']

outliers = logs․filter(logs․response_time > threshold_upper)

outliers․show(5)

Использование таких паттернов позволяет быстро выявить отклонения и принять меры для устранения возможных проблем․

Паттерн 4: Машинное обучение для прогнозирования и классификации

Современные системы обработки логов уже не ограничиваются только аналитикой․ Они используют методы машинного обучения, чтобы не только сегментировать и находить аномалии, но и предсказывать возможные сбои и поведение системы․ Обучение моделей на основе больших данных становится особенно ценным при работе с логами и поверхностными наборами признаков․

Пример использования Spark MLlib для классификации событий

from pyspark․ml․feature import VectorAssembler

from pyspark․ml․classification import RandomForestClassifier

Подготовка данных

assembler = VectorAssembler(inputCols=["response_time", "cpu_usage", "memory_usage"], outputCol="features")

data = assembler․transform(logs)

Обучение модели

rf = RandomForestClassifier(labelCol="severity_level", featuresCol="features")

model = rf․fit(data)

Предсказание

predictions = model․transform(data)

predictions․select("prediction", "severity_level")․show(5)

Подобные техники делают систему более «умной», способной предсказывать события и автоматически классифицировать их в реальные или потенциальные опасности․

Паттерн 5: Визуализация и создание Dashboards

Невозможно недооценивать важность визуализации при работе с логами․ Графики, диаграммы и панели позволяют быстро воспринимать огромные массивы данных и принимать информированные решения․ С помощью Spark и инструментов, таких как Tableau или Grafana, можно создавать интерактивные dashboards, способные обновляться в реальном времени․

Для этого используют экспорт обработанных данных в форматы, подходящие для визуализации:

- JSON

- CSV

- Встраиваемые API

Эффективная обработка логов с помощью Spark — это не просто применение отдельных техник, а комплексная стратегия, включающая подбор оптимальных паттернов для каждой задачи․ Четкая классификация, автоматизация процессов, использование ML и визуализации позволяют создать мощную аналитическую систему, которая не только ускоряет выявление проблем, но и помогает предсказать их возникновение․

Важно помнить, что каждый проект уникален, и правильный выбор паттернов зависит от конкретных целей бизнеса, архитектуры системы и объема данных․ Постоянное освоение новых методов и внедрение лучших практик, залог успешного анализа логов и повышения надежности ваших систем․

Вопрос: Почему использование паттернов обработки логов с помощью Spark так важно для современных IT-компаний?

Использование паттернов позволяет стандартизировать и автоматизировать анализ больших объемов данных, что значительно ускоряет обнаружение проблем, повышает точность диагностики и обеспечивает возможность быстрого принятия решений․ В условиях огромного объема логов и необходимости быстрого реагирования такие подходы позволяют компаниям быть более устойчивыми, эффективными и безопасными․

Подробнее

| Обработка логов — сортировка и фильтрация | Агрегация данных | Обнаружение аномалий | Машинное обучение | Визуализация данных |

| Обработка в реальном времени | Структура логов и форматы данных | Модели машинного обучения для логов | Создание Dashboards | Лучшие практики анализа логов |