- Паттерны для обработки больших объемов логов: эффективные методики и практические советы

- Что такое паттерны обработки логов и зачем они нужны?

- Классификация и основные виды паттернов для больших логов

- Паттерны структурирования данных

- Паттерны фильтрации и сегментации

- Паттерны агрегации и сводных таблиц

- Практические советы по реализации паттернов обработки логов

- Выбор инструментов и технологий

- Автоматизация и скрипты

- Репликация и резервное копирование данных

- Какие перспективы у методов обработки больших логов?

- Вопрос:

- Ответ:

Паттерны для обработки больших объемов логов: эффективные методики и практические советы

В современном мире информационных технологий мы сталкиваемся с постоянным ростом объёмов данных, особенно логов — файлов, в которых фиксируется вся деятельность систем, приложений, серверов. Обработка больших объемов логов становится не просто желательной, а необходимой задачей для специалистов по информационной безопасности, DevOps-инженеров и системных администраторов. В этой статье мы расскажем о паттернах, которые позволяют эффективно анализировать, структурировать и хранить огромные массивы логов, а также поделимся практическими рекомендациями, полученными на нашем опыте.

Что такое паттерны обработки логов и зачем они нужны?

Паттерны — это шаблоны и стандартные подходы к решению определённых задач. В контексте обработки логов они служат для структурирования, фильтрации, резервирования и быстрого поиска информации внутри огромных массивов данных. Используя паттерны, мы можем не только оптимизировать работу с логами, но и существенно повысить качество анализа событий, выявление инцидентов и поддержание безопасности систем.

Основная сложность при работе с большими логами — это их объем и разнообразие. Логи могут состоять из множества различных форматов, содержать временн́ые метки, системные сообщения, ошибочные уведомления, данные о транзакциях и многое другое. Проще говоря, без правильных паттернов российские или зарубежные системы могут потеряться в необъятных потоках данных и просто "зависнуть".

Ниже мы рассмотрим наиболее проверенные решения и алгоритмы, которые помогают справиться с этой задачей:

- Фильтрация и выборка данных

- Стандартизация форматов логов

- Обработка потоков данных в реальном времени

- Архивирование и долгосрочное хранение

- Интеграция с системами аналитики и мониторинга

Классификация и основные виды паттернов для больших логов

Паттерны структурирования данных

Основная идея данного вида паттернов — преобразование хаотичных текстовых логов в структурированные данные, привычные для автоматической обработки. Эти паттерны позволяют организовать логи в таблицы, базы данных или форматы JSON/XML, что облегчает их дальнейший анализ.

Ключевые подходы:

- Парсинг по регулярным выражениям — создание шаблонов, которые извлекают важные параметры из строк логов

- Использование стандартных форматов, например, Common Log Format (CLF) для веб-логов

- Автоматический распознаватель формата, применение скриптов и программных решений, которые определяют структуру данных самостоятельно

Паттерны фильтрации и сегментации

Обработка больших логов невозможна без предварительной фильтрации. Не все события требуют внимания, а избыточная информация мешает быстро находить важные инциденты.

Практическое применение паттернов фильтрации включает:

- Выборка по временным диапазонам

- Фильтрация по уровням важности, ERROR, WARNING, INFO

- Поиск по ключевым словам или кодам ошибок

- Использование ключевых тегов для быстрого поиска

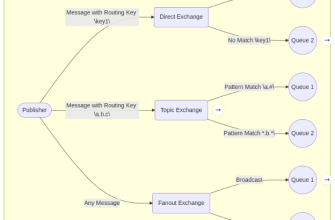

Паттерны агрегации и сводных таблиц

Для анализа больших потоков данных удобно использовать агрегированные показатели — суммарные значения, частоты, тренды по определённым параметрам.

Общие подходы:

- Группировка логов по временным интервалам (например, по минутам, часам)

- Объединение сообщений по типам событий

- Подсчёт числа ошибок или предупреждений за период

| Параметр | Описание | Пример использования | Инструменты | Преимущества |

|---|---|---|---|---|

| Группировка по времени | Анализ событий за выбранный промежуток | Подсчёт ошибок за час | Elasticsearch, Kibana, Grafana | Быстрая визуализация трендов |

| Агрегация по типам событий | Объединить похожие сообщения | Все ошибки сервиса X | Logstash, Graylog | Облегчить поиск причин инцидентов |

Практические советы по реализации паттернов обработки логов

Выбор инструментов и технологий

На сегодняшний день существует множество платформ и решений для обработки больших логов. Среди популярных мы можем выделить:

- ELK Stack (Elasticsearch, Logstash, Kibana) — универсальный инструмент для сбора, анализа и визуализации логов

- Graylog, централизованный сервер логов с мощными возможностями поиска и оповещения

- Prometheus и Grafana, инструменты для мониторинга и аналитики в реальном времени

- Fluentd — универсальный сборщик логов, поддерживающий множество форматов и источников

Автоматизация и скрипты

Чтобы работать с большими объемами данных, важно автоматизировать процессы парсинга, фильтрации и хранения. Для этого можно использовать:

- Python скрипты с регулярными выражениями

- Shell-скрипты для обработки логов на лету

- Конвейеры обработки данных в системах CI/CD

Репликация и резервное копирование данных

Обеспечение сохранности логов — важнейший аспект. Рекомендуется:

- Настроить автоматическое архивирование

- Использовать репликацию данных на удалённые серверы

- Принимать решения по срокам хранения на основе уровня важности

Какие перспективы у методов обработки больших логов?

Поскольку объем данных растёт экспоненциально, развитие автоматизированных методов анализа и обработки также идет вперёд. В ближайшем будущем можно ожидать:

- Использование машинного обучения для автоматического выявления аномалий и прогнозирования событий

- Интеграцию с ИИ-ассистентами для быстрого реагирования на инциденты

- Расширение автоматизированных систем сегментации и фильтрации по многим параметрам

Работа с большими объемами логов — это не только задача техническая, но и стратегическая. Использование правильных паттернов, мощных инструментов и автоматизированных процессов позволяет значительно повысить эффективность и безопасность ваших систем. Не забывайте регулярно обновлять свои подходы и внедрять новые технологии, ведь развитие IT не стоит на месте, а логи — это «живая» история вашей инфраструктуры, которую необходимо уметь читать на лету.

Вопрос:

Почему применение паттернов критично важно для обработки больших объемов логов в современных инфраструктурах?

Ответ:

Паттерны обеспечивают системный, стандартизированный подход к структурированию, фильтрации, агрегации и хранению данных, что существенно упрощает работу с огромными потоками информации. Они позволяют автоматизировать процессы анализа, снизить риск ошибок, ускорять поиск важных событий и предотвращать информационный шум. В конечном итоге, современные системы, использующие паттерны, становятся более надежными, эффективными и готовыми к масштабированию, что особенно важно при росте объемов логов и усложнении инфраструктурных решений.

Подробнее

| Обработка логов в реальном времени | Инструменты анализа логов | Аналитика больших данных | Автоматизация обработки логов | Методы фильтрации логов |

| Стандартизация форматов логов | Агрегация логов для аналитики | Обработка потоков данных | Интеграция систем логирования | Инструменты визуализации логов |