- Паттерны для обработки больших логов в ELK: секреты эффективной аналитики

- Что такое паттерны для обработки логов и зачем они нужны?

- Типы паттернов обработки логов в ELK

- Примеры конкретных паттернов для ELK

- Практические рекомендации по созданию паттернов для больших логов

- Практический пример внедрения паттерна

- Инструменты и советы для автоматизации паттернов в ELK

Паттерны для обработки больших логов в ELK: секреты эффективной аналитики

В современном цифровом мире объем данных растет в геометрической прогрессии. Особенно критичной становится задача обработки и аналитики логов — огромных массивов данных‚ поступающих с различных устройств и систем. ELK-стек (Elasticsearch‚ Logstash‚ Kibana) превратился в мощный инструмент для визуализации‚ поиска и анализа журналов‚ позволяя быстро выявлять проблемы‚ транслировать важную информацию и оптимизировать работу инфраструктуры.

Однако‚ если подойти к обработке больших логов без правильных паттернов и стратегий‚ есть риск столкнуться с серьезными проблемами — потерей данных‚ исчезновением важной информации или снижением скорости обработки. Именно поэтому создание и внедрение специальных паттернов для обработки логов в ELK становится залогом успешного и эффективного анализа масштаба данных.

Что такое паттерны для обработки логов и зачем они нужны?

Паттерны — это заранее определенные шаблоны‚ схемы или алгоритмы‚ которые помогают стандартизировать и автоматизировать процесс обработки логов. Они служат основой для структурирования данных‚ выделения ключевых элементов и оптимизации последующей аналитики.

Если мы не внедрим правильные паттерны‚ нам придется столкнуться с рядом проблем:

- Медленная обработка данных — из-за несогласованных структур логов и избыточной их разнородности.

- Потеря важной информации — в слишком больших массивах данных трудно отличить критичные события.

- Повторяющаяся работа — если не автоматизировать рутинные операции‚ время обработки существенно возрастет.

- Ошибки в интерпретации данных, отсутствие стандартов приводит к неправильному анализу и принятия решений.

Именно поэтому использование паттернов — это не абстрактная идея‚ а практическая необходимость при работе с большими логами.

Типы паттернов обработки логов в ELK

Разработка и внедрение паттернов предполагает создание универсальных и рабочий схем‚ которые позволяют автоматизировать идентификацию‚ фильтрацию‚ агрегацию и визуализацию данных.

Основные типы паттернов:

- Шаблоны парсинга — предназначены для структурирования непредсказуемых и разнородных логов. Включают регулярные выражения‚ grok-шаблоны.

- Фильтрационные паттерны — автоматизируют исключение из обработки мусорных или нерелевантных данных.

- Агрегационные паттерны, помогают объединять связанные события или параметры для анализа.

- Паттерны распределенной обработки — используются при работе с кластерными системами больших данных‚ обеспечивают балансировку и масштабируемость;

- Паттерны для генерации метрик, автоматически создают показатели для мониторинга состояния систем и выявления аномалий.

Примеры конкретных паттернов для ELK

Рассмотрим подробнее наиболее популярные из них:

- Grok-шаблоны — позволяют разбивать сложные шаблоны логов на простые компоненты. Например‚ выделить из строки логов IP-адрес‚ временную метку или уровень ошибки.

- Лог-фильтры для устранения шума, автоматическая фильтрация шаблонов‚ которые не несут ценную информацию.

- Автоматическая сегментация по времени и событиям — позволяет разбивать логи на смысловые блоки‚ что упрощает последующий анализ.

| Тип паттерна | Описание | Использование | Пример |

|---|---|---|---|

| Grok-шаблон | Шаблон для структурирования логов | Парсинг логов разных систем | %{IPV4:client_ip} %{WORD:method} %{URIPATH:request_path} |

| Фильтр шума | Исключение нерелевантных данных | Удаление повторных ошибок | NOT %{LOGLEVEL:level} ERROR |

| Агрегация по времени | Объединение событий за определенный интервал | Анализ пиков нагрузки | 10mmax count |

Практические рекомендации по созданию паттернов для больших логов

Создавать эффективные паттерны — это искусство и наука одновременно. Ниже представляем список рекомендаций‚ которые помогут вам сделать этот процесс максимально понятным и результативным.

- Анализируйте типы логов — перед началом работы убедитесь‚ что понимаете особенности каждого источника данных. Для этого изучите их структуру и ключевые параметры.

- Стандартизируйте форматы — используйте общие шаблоны и соглашения для всех логов‚ чтобы облегчить их парсинг и последующую обработку.

- Используйте регулярные выражения с умом — старайтесь писать лаконичные и быстрые в исполнении регулярные выражения‚ избегайте избыточности.

- Тестируйте паттерны на небольших выборках — прежде чем запускать массовую обработку‚ тщательно протестируйте шаблоны на реальных логах.

- Автоматизируйте создание паттернов — используйте парсеры‚ генераторы шаблонов и инструменты для быстрого создания новых паттернов по образцу.

- Обеспечивайте масштабируемость, проектируйте паттерны так‚ чтобы они легко справлялись с увеличением объемов данных и расширением источников логов.

- Обновляйте и оптимизируйте паттерны — логика обработки должна постоянно совершенствоваться по мере появления новых типов данных и требований.

- Документируйте созданные паттерны, наличие четких описаний ускоряет работу команды и снижает вероятность ошибок.

- Применяйте паттерны последовательно — автоматизация и стандартизация снижают шанс ошибок и позволяют легко масштабировать решения.

- Используйте аналитические инструменты — визуализации и отчеты помогают понять эффективность паттернов и выявлять узкие места.

Практический пример внедрения паттерна

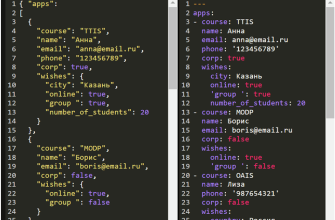

Рассмотрим сценарий‚ когда в логах часто встречаются ошибки с IP-адресами и временными метками. Нам нужно структурировать эти данные‚ чтобы легче их анализировать.

Первый шаг — создание grok-шаблона:

%{IPV4:client_ip} [%{HTTPDATE:timestamp}] %{LOGLEVEL:level} %{GREEDYDATA:message} Этот шаблон позволяет разбивать строки логов на основные компоненты: IP-адрес клиента‚ временную метку‚ уровень логирования и сообщение. После этого можно:

- Фильтровать важные события по уровню.

- Создавать дашборды для мониторинга частоты ошибок по IP.

- Автоматически оповещать команду о критичных сбоях.

Такой подход значительно упрощает работу с большими объемами данных и помогает своевременно реагировать на возникающие проблемы.

Инструменты и советы для автоматизации паттернов в ELK

Для успешной автоматизации процессов создания паттернов стоит использовать различные инструменты и подходы:

- Grok Debugger, встроенный инструмент Kibana для тестирования grok-шаблонов.

- Logstash конфигурации — позволяют создавать многоразовые шаблоны обработки логов;

- Автоматизация через скрипты, Python‚ Bash или другие языки с возможностью генерации и проверки паттернов.

- Использование шаблонов из внешних источников — GitHub-репозитории и публичные базы данных шаблонов.

- Регулярное обновление и тестирование — автоматические CI/CD пайплайны‚ включающие проверку новых паттернов.

Постоянная интеграция и тестирование обеспечивают стабильность и актуальность используемых методов обработки логов.

Обрабатывая большие объемы логов‚ важно не только создавать Идеальные паттерны‚ но и внедрять их в рабочие процессы. Регулярное обновление‚ тестирование и автоматизация позволяют минимизировать ошибки и ускорить процесс аналитики.

В конце концов‚ правильные паттерны для ELK, это грамотное инвестирование времени и ресурсов‚ которое окупается ростом эффективности‚ снижением времени отклика и повышением точности анализа.

Вопрос: Какие основные паттерны стоит внедрить для обработки больших логов в ELK‚ чтобы повысить их эффективность?

Ответ: Основные паттерны включают grok-шаблоны для структурирования логов‚ фильтры для исключения нерелевантных данных‚ агрегационные схемы для объединения связанных событий‚ а также автоматические сценарии для регулярной актуализации и тестирования этих шаблонов. В комбинации они позволяют значительно ускорить обработку‚ повысить точность анализа и автоматизировать многие рутинные задачи.

Подробнее

| масштабируемая обработка логов | структурированные логи в ELK | шаблоны grok для логов | автоматизация фильтров ELK | оптимизация логов ELK |

|---|---|---|---|---|

| анализ больших данных в ELK | гибкое парсирование логов | автоматическая сегментация логов | настройки паттернов ELK | набор лучших практик ELK |