- Паттерны для обработки больших JSON-файлов: эффективные стратегии и практические советы

- Что такое большие JSON-файлы и с чем они связаны?

- Основные вызовы при работе с большими JSON-файлами

- Паттерн 1: Построчное чтение файла (Streaming)

- Инструменты и библиотеки для потокового чтения

- Пример реализации на Python – использование ijson

- Паттерн 2: Использование генераторов и ленивой загрузки

- Плюсы использования генераторов

- Пример на Python

- Паттерн 3: Использование разделения файла (Chunking)

- Методы разделения файла

- Пример логики для Python с использованием буфера

- Паттерн 4: Использование баз данных и индексов

- Почему использовать базы данных?

- Пример: импорт JSON в MongoDB

- Ошибки, которых стоит избегать при работе с большими JSON

- Резюме: ключевые моменты для успешной работы с большими JSON

- Вопрос и ответ

Паттерны для обработки больших JSON-файлов: эффективные стратегии и практические советы

В современном мире данные играют ключевую роль. Особенно важным стал формат JSON (JavaScript Object Notation), благодаря своей легкости, гибкости и универсальности. Однако, когда объем данных достигает гигантских размеров — сотни МБ или даже несколько ГБ — возникают новые сложности. Обработка таких больших JSON-файлов требует особых подходов и паттернов, чтобы не только выполнить задачу, но и сделать это максимально эффективно.

Обработка больших файлов — это не просто чтение и запись. Это вопрос оптимизации памяти, скорости и надежности. Поэтому сегодня мы расскажем о наиболее эффективных паттернах и стратегиях работы с крупными JSON-документами, чтобы вы смогли легко и быстро решать подобные задачи, не сталкиваясь с типичными ошибками и узкими местами.

Что такое большие JSON-файлы и с чем они связаны?

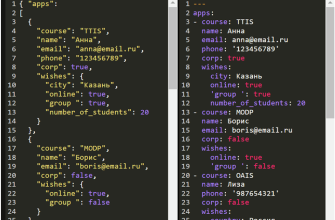

Большие JSON-файлы, это файлы, содержащие огромное количество структурированных данных, которые зачастую превышают возможности стандартных методов разовой загрузки в память. Такие файлы могут возникать в различных сценариях:

- Логирование больших объемов данных

- Экспорт и импорт больших баз данных или отчетов

- Обработка данных IoT, где устройства отправляют большие последовательности сообщений

- Анализ больших объемов данных на бигдата платформах

Многие разработчики сталкиваются с проблемой: стандартные библиотеки и методы работают плохо или полностью перестают действовать с увеличением объема данных. В таком случае необходимо использовать специальные паттерны и подходы, которые позволяют эффективно работать с такими файлами.

Основные вызовы при работе с большими JSON-файлами

Перед тем как рассматривать паттерны, важно понять, с какими вызовами мы сталкиваемся:

- Память: большие файлы часто не помещаются полностью в RAM, что вызывает OutOfMemory ошибки.

- Скорость обработки: чтение файла полностью или разбор его структуры занимает много времени.

- Производительность: операции сериализации и десериализации требуют ресурсов процессора.

- Обработка ошибок: снижение устойчивости при ошибках чтения или некорректных данных.

Чтобы успешно решать эти проблемы, необходимо применять специальные паттерны, позволяющие минимизировать использование памяти, повысить скорость и стабильно обрабатывать любые объемы данных.

Паттерн 1: Построчное чтение файла (Streaming)

Самый популярный и эффективный паттерн при обработке больших JSON — это потоковое чтение и обработка данных. Такой подход позволяет читать файл по частям, не загружая весь объем сразу в память.

Как работает:

- Используем библиотеки, поддерживающие потоковое чтение JSON.

- Обрабатываем каждую часть файла по мере его чтения.

- Освободив память, переходим к следующему фрагменту.

Инструменты и библиотеки для потокового чтения

| Язык программирования | Библиотека / инструмент | Описание |

|---|---|---|

| Python | ijson | Библиотека для потокового парсинга JSON, работающая по принципу итераторов |

| JavaScript | JSONStream | Позволяет читать JSON как поток, обрабатывая по частям |

| Java | Jackson Streaming API | Обеспечивает быстрый потоковый парсинг больших JSON-файлов |

Пример реализации на Python – использование ijson

import ijson

with open('large_file.json', 'r') as f:

for item in ijson.items(f, 'items.item'):

# Обработка каждого элемента по мере чтения

process(item)

Данный однострочник позволяет последовательно получать объекты, не загружая весь файл полностью в память. Такой подход идеально подходит для обработки логов, больших списков и подобных данных.

Паттерн 2: Использование генераторов и ленивой загрузки

Этот паттерн строится на концепции генераторов — функций, возвращающих объект итератора, который «лениво» подгружает данные по мере необходимости.

Генераторы позволяют разбивать обработку больших данных на небольшие порции, постепенно извлекая и обрабатывая информацию, что значительно снижает нагрузку на память.

Плюсы использования генераторов

- Минимизация потребления памяти

- Гибкость в обработке данных под ваши нужды

- Позволяют подготовить обработку с несколькими шагами

Пример на Python

def parse_large_json(file_path):

with open(file_path, 'r') as f:

for line in f:

yield json.loads(line)

for data in parse_large_json('big.json'):

process(data)

Данный пример предполагает формат JSON, где каждый объект находится в отдельной строке. Для более сложных структур нужны специальные парсеры и методы.

Паттерн 3: Использование разделения файла (Chunking)

Иногда, чтобы удобно обработать очень большой файл, рекомендуется заранее разбить его на более мелкие части — так называемые чанки. Это облегчает работу с файлами, позволяет параллельно обрабатывать несколько частей и уменьшает риск ошибок.

Естественно, при использовании этого метода важно сохранять целостность данных, чтобы не потерять смысл и структуру информации.

Методы разделения файла

- Ручное деление: разбивка посредством скриптов или утилит (например, `split` в Linux).

- Автоматизированное деление: скрипты, которые по определенным признакам разбивают файл на части.

- Динамическое чтение: при обработке читать блоки данных по частям (например, по 1МБ).

Пример логики для Python с использованием буфера

def process_in_chunks(file_path, chunk_size=1024*1024):

with open(file_path, 'r') as f:

buffer = ''

for line in f:

buffer += line

if len(buffer) >= chunk_size:

yield json.loads(buffer)

buffer = ''

if buffer:

yield json.loads(buffer)

Паттерн 4: Использование баз данных и индексов

Когда объем данных действительно очень большой, хранение их в файлах становится менее эффективным, а работа с базой данных, гораздо удобнее. Особенно, если необходимо часто искать и фильтровать данные.

Обработка больших JSON-документов может включать импорт данных в реляционные или NoSQL базы данных, что позволяет использовать индексирование и быстрые запросы.

Почему использовать базы данных?

- Быстрый поиск по критериям

- Обработка выборок данных без загрузки всего файла

- Масштабируемость

- Поддержка транзакций и консистентности

Пример: импорт JSON в MongoDB

mongoimport --db your_db --collection your_collection --file big.json --jsonArray После импорта можно искать данные с помощью MongoDB по индексам, что значительно ускоряет обработку.

Ошибки, которых стоит избегать при работе с большими JSON

Даже самый правильный паттерн иногда может привести к ошибкам или слабым результатам, если к ним подходить неправильно. Вот несколько распространенных ошибок:

- Попытка полностью загрузить весь файл без потоковой обработки

- Игнорирование ошибок при парсинге –(например, наличие некорректных данных)

- Недостаточное тестирование на небольших данных перед запуском на больших

- Неиспользование надежных библиотек и инструментов

Важно помнить: при работе с большими данными — это всегда игра в долгую и аккуратное планирование.

Выбор подходящего паттерна зависит от конкретных условий задачи: объема данных, требуемой скорости, ресурсов системы и целей обработки. Обратите внимание:

- Если بسرعة нужно обработать огромный файл — лучше использовать потоковое чтение и парсинг.

- Для обработки данных в режиме offline, подойдет разбивка на части (chunking).

- Если нужны сложные запросы — стоит рассматривать базы данных;

Оптимальная стратегия — комбинирование нескольких паттернов, например, потокового чтения с использованием генераторов и сохранением промежуточных результатов в базе данных.

Резюме: ключевые моменты для успешной работы с большими JSON

- Используйте потоковое чтение для минимизации использования памяти.

- Работайте с генераторами для эффективной ленивой загрузки данных.

- Разделяйте файл на части для параллельной обработки.

- Рассматривайте возможность хранения в базах данных для ускорения запросов.

- Тестируйте весь процесс на небольших объемах перед запуском на большие данные.

Вопрос и ответ

Вопрос: Какие паттерны наиболее подходят для обработки JSON-файлов объемом более 10 ГБ?

Ответ: Для обработки очень больших JSON-файлов свыше 10 ГБ рекомендуется использовать потоковый парсинг с библиотеками, поддерживающими работу по частям (например, ijson для Python или Jackson Streaming API для Java). Также целесообразно разбивать файлы на меньшие части (chunking) и, если есть необходимость, импортировать данные в базы данных для быстрого поиска и аналитики. Важным аспектом является избегать полной загрузки файла в память и использовать генераторы для ленивой обработки данных. Такой подход позволяет значительно снизить нагрузку на систему и повысить скорость обработки даже очень объемных данных.

Подробнее

| Обработка JSON в Python | Потоковая загрузка данных | Работа с большими файлами | Базы данных для JSON | Ленивая обработка данных |

| Оптимизация памяти при парсинге | Chunking больших файлов | Использование генераторов | Параллельная обработка JSON | Реальные кейсы big data JSON |