- Паттерны для обработки больших JSON-файлов: эффективные стратегии и инструменты

- Почему важно правильно подходить к обработке больших JSON-файлов?

- Общие принципы и паттерны обработки больших JSON-файлов

- Построчная обработка (Streaming parsing)

- Пример использования streaming parsing на Python

- Разделение файла на части (Chunking)

- Пример разбивки файла с помощью jq

- Использование базы данных или хранилища

- Практический пример: обработка большого файла JSON с помощью Python и Pandas

- Инструменты и библиотеки для работы с большими JSON

- Советы по оптимизации обработки больших JSON-файлов

- Вопрос и ответ

- Подробнее

Паттерны для обработки больших JSON-файлов: эффективные стратегии и инструменты

Когда мы сталкиваемся с необходимостью обработки больших JSON-файлов, перед нами открывается целый ряд вопросов и задач. Как эффективно загрузить и разобрать огромные объемы данных, не перегружая память? Какие паттерны и подходы помогут сделать обработку более надежной и быстрой? В нашей статье мы поделимся личным опытом, разберем основные принципы, предложим практические решения и подскажем инструменты, которые используют профессионалы в работе с большими данными.

Почему важно правильно подходить к обработке больших JSON-файлов?

JSON, это один из самых популярных форматов обмена данными в современном мире. Он читаемый и удобный для передачи структурированных данных, однако при росте объема файл становится всё тяжелее, и стандартные методы парсинга начинают работать с задержками. Неправильный подход к обработке больших JSON-файлов может привести к переполнению памяти, снижению скорости работы и даже к сбоям.

Именно поэтому важно использовать подходы и паттерны, которые позволяют:

- эффективно загружать большие объемы данных

- обрабатывать их по частям

- минимизировать использование памяти

- поддерживать масштабируемость

Общие принципы и паттерны обработки больших JSON-файлов

Существует несколько ключевых подходов, которые используются для эффективной работы с большими JSON-данными. Ниже мы расскажем о наиболее проверенных и популярных паттернах.

Построчная обработка (Streaming parsing)

Этот паттерн позволяет обрабатывать JSON-данные по частям, поступающим потоком. Вместо того чтобы загружать весь файл в память, мы читаем его по строкам или блокам. Для этого отлично подходят такие инструменты как ijson для Python или Jackson Streaming API для Java.

Преимущества этого подхода:

- Минимум использования памяти

- Высокая скорость обработки

- Возможность обработки данных, которые поступают по сети или из другого источника

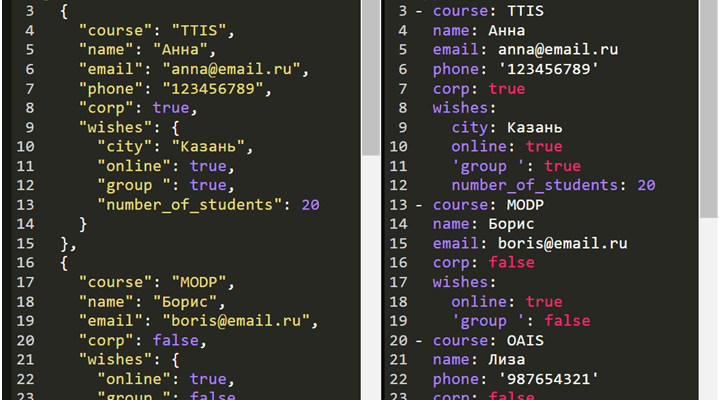

Пример использования streaming parsing на Python

import ijson

with open('large_file.json', 'r') as f:

parser = ijson.parse(f)

for prefix, event, value in parser:

if (prefix, event) == ('items.item', 'start_map'):

# Обработка каждого элемента по мере чтения

print('Обнаружен элемент:', value)

Разделение файла на части (Chunking)

Если файл очень большой и его невозможно обработать целиком, разумным решением становится его разделение на меньшие части. Это можно делать вручную или автоматизировано с помощью специальных скриптов. После разделения каждая часть обрабатывается отдельно, что значительно снижает нагрузку на ресурсы системы.

Общие рекомендации:

- Используйте инструменты для разбивки файла, такие как jq, split в Linux или собственные скрипты на Python или Bash

- Обрабатывайте части последовательно, избегая параллельной обработки для избегания конфликтов

- Объединяйте результаты после обработки для получения итоговых данных

Пример разбивки файла с помощью jq

jq -c '.items[]' large.json | split -l 1000 ‒ chunk_

Использование базы данных или хранилища

Иногда наиболее целесообразным решением становится загрузка данных из JSON в базу данных или другое хранилище. Такой подход позволяет управлять большими объемами информации, осуществлять быстрый поиск и аналитику.

Пошаговая схема:

- Парсинг JSON и поэтапная загрузка элементов в базу

- Обеспечение индексирования и поиска по ключам

- Обработка и обновление данных через SQL или NoSQL системы

В качестве инструментов рекомендуется использовать MongoDB, Elasticsearch или PostgreSQL в зависимости от задач.

Практический пример: обработка большого файла JSON с помощью Python и Pandas

Рассмотрим реальный кейс: необходимо обработать файл размером более 10ГБ, содержащий список заказов. Стандартное чтение полностью файла было невозможно из-за ограничения памяти. Мы решили использовать подход потокового чтения.

| Шаг | Описание | Инструменты |

|---|---|---|

| 1 | Построчное чтение файла и парсинг элементов | Python, ijson |

| 2 | Обработка каждого элемента: фильтрация или агрегирование | Python, pandas |

| 3 | Запись результатов в базу данных или файл | SQLite, CSV, JSON |

Такой подход позволяет обработать огромные объемы данных, не создавая лишней нагрузки на систему.

Инструменты и библиотеки для работы с большими JSON

Использование правильных инструментов существенно облегчает задачу. Ниже представлен список наиболее популярных и проверенных библиотек:

- ijson, потоковый парсер JSON для Python

- Jackson Streaming API — потоковая обработка JSON для Java

- simdjson — быстрая библиотека для парсинга JSON на C++ и Python

- jq — инструмент командной строки для обработки JSON

- Pandas — аналитика данных при работе с файлами в блоках

Советы по оптимизации обработки больших JSON-файлов

Чтобы максимально эффективно справляться с крупными JSON-данными, стоит учитывать следующие рекомендации:

- Используйте потоковую обработку — избегайте загрузки всего файла в память

- Разделяйте большие файлы на части для последовательного анализа

- Работайте с индексами и базами данных — для быстрого поиска и хранения

- Оптимизируйте парсинг — используйте библиотеки, написанные на низкоуровневых языках

- Параллелизация задач — распределите обработку по нескольким потокам или узлам

Выбор паттерна зависит от конкретных условий задачи: объема данных, требований к скорости, наличия ресурсов. Для небольших файлов подойдет потоковая обработка и чтение по частям, для огромных, загрузка в базу или распределенная обработка. Важно помнить, что правильное решение значительно повышает эффективность работы и снижает риски ошибок.

Цель нашей статьи — помочь вам выбрать наиболее подходящие подходы и инструменты для работы с большими JSON-файлами, поделиться личным опытом и знаниями, чтобы ваш проект стал более быстрым и надежным.

Это не только вопрос технических навыков, но и стратегии — правильный паттерн позволяет не переполнить память, ускорить работу и обеспечить стабильность системы.

Вопрос и ответ

Вопрос: Какие методы наиболее подходят для обработки файлов размером свыше 10 ГБ в условиях ограниченных ресурсов компьютера?

Ответ: В этом случае наиболее эффективными являются потоковая обработка (streaming parsing) и разделение файла на части (chunking). Эти подходы позволяют минимизировать использование оперативной памяти и избежать перегрузки системы, сохраняя при этом высокую скорость обработки. Также целесообразно использовать базы данных или индексированные хранилища для хранения и быстрого поиска данных, а обработку разделять на параллельные задачи, если есть возможность. Самое главное — избегать загрузки всего файла целиком, а работать по частям и инструментами, поддерживающими потоковую обработку.

Подробнее

10 LSI запросов к статье

| Обработка больших JSON-файлов | Stream parsing JSON | Chunking больших данных | Базы данных для хранения JSON | Инструменты для работы с JSON |

| Оптимизация обработки JSON | Парсинг JSON на Python | Обработка JSON потоками | Паттерны работы с большими данными | Инструменты для разделения JSON |