- Паттерны для обработки больших файлов: эффективные стратегии и проверенные методы

- Основные принципы обработки больших файлов

- Паттерны для эффективного чтения и записи данных

- Техники разбивки и параллельной обработки

- Разбиение файла на части

- Параллельная обработка

- Обработка ошибок и восстановление данных

- Практический пример восстановления

- Оптимизации производительности и практические советы

- Практические рекомендации:

- Теперь вы знаете, как эффективно работать с большими файлами, используя проверенные паттерны и техники

- Вопрос:

- Ответ:

Паттерны для обработки больших файлов: эффективные стратегии и проверенные методы

Когда мы сталкиваемся с необходимостью обработки больших файлов, будь то лог-файлы, базы данных или объемные наборы данных для аналитики, у нас зачастую возникает множество вопросов: как справиться с такими объемами, чтобы это было быстро, надежно и не тратило слишком много ресурсов? В рамках этого обзора мы поделимся своим опытом и расскажем о наиболее популярных и эффективных паттернах, применяемых при работе с большими файлами;

Обработка больших данных — это особое искусство, в котором важна каждая деталь. Невозможно просто взять и открыть гигабайты информации как обычный файл. Требуются специальные подходы, практики и паттерны, позволяющие минимизировать время выполнения операций, снизить нагрузку на систему и обеспечить целостность данных. В этом руководстве мы разберем:

- Основные принципы обработки больших файлов

- Паттерны для эффективного чтения и записи данных

- Техники разбивки и параллельной обработки

- Обработка ошибок и восстановление данных

- Оптимизации производительности и практические советы

Основные принципы обработки больших файлов

Перед тем как углубляться в конкретные паттерны, важно понять основные принципы, которые лежат в основе правильной обработки больших файлов. Даже самый эффективный паттерн не поможет, если не учитывать такие базовые вещи, как скорость доступа к дискам, возможности памяти и особенности используемого формата данных.

Чтобы избежать множественных ошибок и повысить эффективность, мы выделили следующие ключевые принципы:

- Понимание формата данных: Перед началом работы важно знать структуру файла — его кодировку, формат хранения, метаданные и особенности.

- Минимизация чтения и записи: Стараться минимизировать количество операций ввода-вывода, особенно при работе с файловыми системами, где каждая операция требует времени.

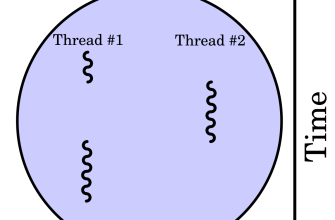

- Параллельная обработка: Использовать возможности многопоточности или многопроцессорных систем для ускорения обработки.

- Использование буферизации: В некоторых случаях разумной стратегией является буферизация данных для сокращения количества операций.

- Обработка ошибок: Продуманное восстановление данных и механизмы повторных попыток обеспечивают целостность при сбоях.

Паттерны для эффективного чтения и записи данных

Одним из фундаментальных аспектов обработки больших файлов является алгоритмическая стратегия чтения и записи. Переключение с простого поблочного чтения на более умные паттерны позволяет значительно повысить производительность.

| Паттерн | Описание | Преимущества |

|---|---|---|

| Построчное чтение | Чтение файла по одной строке, полезно для лог-файлов или потоковых данных. | Меньшее использование памяти, позволяет работать с файлами практически любого размера. |

| Буферизация чтения/записи | Использование буферов для чтения больших блоков данных за один раз. | Снижение количества обращений к диску, ускорение операций. |

| Параллельная обработка блоков | Разделение файла на части и обработка их одновременно в нескольких потоках/процессах. | Значительное сокращение времени обработки. |

| Использование потоков | Использование потоков для чтения/записи данных асинхронно. | Повышение эффективности за счет параллельных операций. |

Техники разбивки и параллельной обработки

Обработка гигабайтных файлов в рамках одного процесса зачастую невозможна или неэффективна. Поэтому важным паттерном становится разбивка файла на части и дальнейшая параллельная обработка. Такой подход позволяет не только ускорить работу, но и уменьшить требования к оперативной памяти.

Разбиение файла на части

Разделение файла делается в два основных режима:

- Фиксированный размер блоков: деление файла на блоки фиксированной длины, например, по 100 МБ или по 1 ГБ.

- По меткам или разделителям: разделение по какому-либо маркеру, например, строке или разделителю.

Для реализации такого метода используют различные инструменты и библиотеки. Например, в Python существует модуль fileinput и возможность работать с файлами побочно через потоковые операции для определения точек разбиения.

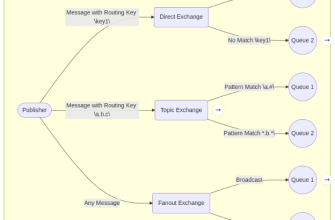

Параллельная обработка

После разбиения файла наступает очередь распараллеливания задач. В зависимости от используемого языка программирования и среды можно реализовать:

- Многопоточную обработку: запуск нескольких потоков, каждый из которых обрабатывает свою часть файла.

- Многопроцессорную обработку: запуск процессов параллельно, каждый работает с определенным блоком данных.

Важной момент заключается в контроле целостности данных и корректности результатов после параллельной обработки. Для этого создаются системы контроля версий, хеш-сумм или механизмы мёржа обработанных частиц.

Обработка ошибок и восстановление данных

Работа с большими файлами никогда не обходится без ошибок, сбое при чтении, повреждении данных или системных сбоях. Поэтому важна стратегия обработки ошибок.

Используемые паттерны:

- Логирование ошибок: все сбои фиксируются для последующего анализа.

- Резервное копирование: создание резервных копий данных перед началом обработки.

- Обеспечение идемпотентности: возможность повторного выполнения процессов без ущерба для данных.

- Восстановление по контрольным суммам: автоматическая проверка целостности данных;

Практический пример восстановления

Если при обработке файла обнаруживаеться повреждение строки, лучше всего реализовать механизм пропуска и логирования таких участков, чтобы не останавливать весь процесс.

Оптимизации производительности и практические советы

За годы работы с большими файлами мы пришли к ряду практических рекомендаций, которые значительно улучшают эффективность обработки данных.

Практические рекомендации:

- Используйте потоковую обработку данных вместо загрузки всего файла в память.

- Настраивайте размер буфера под особенности вашей системы, оптимальный размер может варьироваться.

- Применяйте асинхронные операции, чтобы максимально задействовать ресурсы.

- Параллелите задачи, если есть возможность распределять обработку по CPU.

- Профилируйте свои скрипты и программы, измерьте время выполнения различных операций и выявляйте узкие места.

Также не стоит забывать о тестировании и моделировании обработки больших файлов на тестовых данных. Это помогает понять возможные проблемы и найти наиболее подходящие решения.

Теперь вы знаете, как эффективно работать с большими файлами, используя проверенные паттерны и техники

Обработка больших данных — это не только вопрос быстродействия, но и вопрос надежности, адаптивности и экономии ресурсов. Использование правильных паттернов для чтения, обработки, разбивки и восстановления позволяет делать работу не только эффективной, но и безопасной. Помните, что практика и опыт — лучшие учителя. И уже сегодня внедряйте описанные подходы в ваши проекты, и результаты не заставят себя ждать.

Вопрос:

Что является самым важным при выборе паттернов для обработки больших файлов?

Ответ:

Самым важным является понимание особенностей конкретных данных и условий обработки. Необходимо учитывать формат файла, аппаратное обеспечение, требования к скорости и надежности, а также цели проекта. Только исходя из этих факторов можно выбрать наиболее подходящие паттерны: будь то разбивка файла, параллельная обработка, оптимизация операций ввода-вывода или механизмы восстановления данных.

Подробнее

| обработка больших файлов | паттерны для больших данных | параллельная обработка файлов | разбиение больших файлов | оптимизация чтения файлов |

| обработка лог файлов | многопроцессорная обработка | инструменты для обработки больших данных | восстановление данных из файлов | советы по обработке больших файлов |

| эффективное чтение файлов | обработка больших данных Python | паттерны для потоков | дапка монорепозиторий обработки данных | предотвращение ошибок при работе с файлами |

| выгрузка больших данных | эффективные алгоритмы обработки данных | параллельное программирование | предобработка данных | кодирование и сжатие данных |