- Паттерны для обработки больших данных в памяти: секреты эффективной работы с масштабными массивами информации

- Что такое паттерны обработки больших данных в памяти?

- Основные паттерны для обработки больших данных в памяти

- Поточно-ориентированная обработка (Stream Processing)

- Примеры реализации

- Разделение данных и параллельная обработка (Data Partitioning)

- Практические кейсы

- Использование инкрементальных и ленивых вычислений

- Преимущества

- Практические советы по выбору паттерна для своих задач

- Практические примеры из личного опыта

Паттерны для обработки больших данных в памяти: секреты эффективной работы с масштабными массивами информации

—

В современном мире объем данных, который генерируется каждую секунду, достигает невообразимых масштабов. Компании, исследователи и разработчики сталкиваются с необходимостью анализа миллиардов строк информации за кратчайшие сроки. Без правильных стратегий и паттернов обработки таких данных, задача становится практически невозможной. Мы в этой статье подробно расскажем о наиболее эффективных паттернах работы с большими массивами данных в памяти, поделимся личным опытом и практическими советами, которые помогут вам значительно повысить производительность и снизить затраты ресурсов.

Что такое паттерны обработки больших данных в памяти?

Паттерны — это проверенные решения или стратегии, которые помогают структурировать и оптимизировать обработку огромных объемов информации. В контексте работы в памяти, речь идет о методах организации, быстрого поиска, фильтрации и анализа данных, чтобы минимализировать использование ресурсов и повысить скорость выполнения задач.

Работа с большими данными в памяти особенно важна в случаях, когда задержки на чтение/запись на диск недопустимы, или когда требуется мгновенная реакция системы. Такие подходы позволяют не только ускорить анализ данных, но и сделать его более масштабируемым и устойчивым к нагрузкам.

Основные паттерны для обработки больших данных в памяти

Поточно-ориентированная обработка (Stream Processing)

Этот паттерн предполагает обработку данных в режиме реального времени по мере их поступления. Вместо загрузки всей выборки в память, мы обрабатываем поток данных по частям. Такой подход особенно актуален для анализа потоков событий, логов или финансовых транзакций.

Преимущества:

- Минимизация использования памяти — обрабатываем только текущие данные.

- Быстрая реакция — вывод результатов практически мгновенно.

- Масштабируемость — легко увеличиваем объем обрабатываемых данных за счет распределения.

Примеры реализации

| Технология | Описание |

|---|---|

| Apache Kafka | Платформа потоковой передачи данных, позволяющая обрабатывать огромные потоки информации в реальном времени. |

| Apache Flink | Фреймворк для потоковой обработки данных с возможностью сложных аналитических вычислений. |

Разделение данных и параллельная обработка (Data Partitioning)

Этот паттерн предполагает разбиение большого набора данных на меньшие части — сегменты или разделы, которые затем обрабатываются параллельно.

Важность разделения:

- Оптимизация использования CPU — каждая часть обрабатывается отдельным ядром или узлом.

- Повышение скорости — параллельность сокращает время выполнения задач.

- Масштабируемость — легко добавлять новые узлы для обработки увеличивающегося объема данных.

Практические кейсы

| Тип данных | Способ разделения | Область применения |

|---|---|---|

| Логи посещений сайта | Разделение по временным интервалам | Аналитика поведения пользователя |

| Финансовые транзакции | Разделение по клиентским регионам | Фрод-мониторинг и учет |

Использование инкрементальных и ленивых вычислений

При работе с большими объемами данных важно избегать повторной обработки одних и тех же данных. Этот паттерн подразумевает накопление результатов по мере поступления новых данных, без необходимость пересчитывать всю выборку заново.

Как реализовать:

- Использовать кэширование — сохранять промежуточные результаты.

- Применять ленивое вычисление — вычислять только при необходимости.

- Обновлять показатели по мере поступления данных — минимизация времени отклика.

Преимущества

| Преимущество | Описание |

|---|---|

| Эффективность | Минимизация повторных вычислений и ускорение получения итогов. |

| Гибкость | Обновление данных без необходимости полной переработки. |

Практические советы по выбору паттерна для своих задач

Каждая обработка больших данных уникальна, и выбрать подходящий паттерн не просто. Но есть несколько универсальных правил, которые помогут сделать правильный выбор:

- Анализировать характер данных — потоковые, статические, структурированные или нет.

- Определять требования к скорости обработки — нужна мгновенная реакция или можно подождать итоговых результатов.

- Об оценке масштабов — сколько данных и как быстро они растут.

- Исследовать ресурсы — вычислительные мощности и инфраструктуру.

Исходя из этого, выбирайте паттерн, наиболее подходящий под ваши условия. Например, для мгновенного мониторинга рекомендуется потоковая обработка; для аналитической отчетности — разбиение данных и кэширование.

Практические примеры из личного опыта

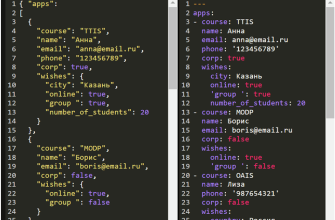

Работая не один год с большими объемами данных, мы сталкивались с разными задачами. Одной из наиболее типичных был анализ логов пользовательских сессий на крупном интернет-ресурсе. В начале проект казался непреодолимым — миллиарды строк данных, требующих анализа. Благодаря применению паттерна разделения данных по временным интервалам и параллельной обработки, нам удалось значительно сократить время анализа.

Еще одним важным примером стала задача обработки финансовых транзакций в реальном времени для системы мониторинга мошенничества. Здесь без потоковой обработки и инкрементальных вычислений не обойтись. Мы использовали Apache Flink и Apache Kafka, что позволило мгновенно реагировать на подозрительные операции и минимизировать штрафные санкции и убытки компании.

Обработка больших данных — это не только вызов технической сложности, но и возможность значительно повысить эффективность бизнеса. Главное — понять специфику своих данных, требования к скорости обработки и наличия ресурсов. Грамотно выбрав и реализовав соответствующий паттерн, вы сможете не только ускорить аналитику, но и сделать систему более устойчивой и масштабируемой.

Помните: успех в обработке больших данных достигается через сочетание правильных решений, технологий и постоянного обучения. Надеемся, что наши советы и личный опыт послужат вам хорошей базой для дальнейших экспериментов и открытий.

Вопрос: Какие основные паттерны обработки больших данных в памяти существуют и чем они отличаются друг от друга?

Ответ: Основные паттерны обработки больших данных в памяти включают потоковую обработку (Stream Processing), разделение данных и параллельную обработку (Data Partitioning), а также инкрементальные и ленивые вычисления. Поточная обработка предназначена для анализа данных в реальном времени, что важно для мгновенного реагирования. Разделение данных помогает масштабировать задачи за счет параллельной обработки сегментов данных, ускоряя работу с большими наборами информации. Инкрементальные и ленивые вычисления позволяют обновлять результаты по мере поступления новых данных без переработки всей выборки, что значительно экономит ресурсы и время. Все эти паттерны имеют свои преимущества и используют разные техники для повышения эффективности и масштабируемости обработки больших данных в памяти.

Подробнее

| Обработка потоков данных | Технологии и подходы к обработке данных в реальном времени | Параллельная обработка данных | Преимущества и особенности распределенных систем | Инструменты для обработки больших данных |

| Разделение данных | Методы разбивки и распределения данных для параллельных систем | Обработка сегментов данных | Кейсы использования | Лучшие практики и рекомендации |

| Инкрементальные вычисления | Обновление результатов по мере поступления новых данных | Ленивые вычисления | Преимущества | Инструменты и технологии |